Cisco Data Center Infrastructure 2.5 Design Guide

Server Cluster Designs with Ethernet

přehled serverů a síťových komponent používaných v modelu clusteru serveru je uveden v kapitole 1 “ Přehled architektury datového centra.“Tato kapitola podrobněji popisuje účel a funkci každé vrstvy modelu clusteru serveru. Následující oddíly jsou zahrnuty:

•![]() technické cíle

technické cíle

•![]() distribuované předávání a latence

distribuované předávání a latence

•![]() rovné náklady Multi-cesta směrování

rovné náklady Multi-cesta směrování

•![]() návrh clusteru serverů-dvoustupňový Model

návrh clusteru serverů-dvoustupňový Model

•![]() návrh clusteru serverů-třístupňový Model

návrh clusteru serverů-třístupňový Model

•![]() doporučený Hardware a moduly

doporučený Hardware a moduly

Poznámka ![]() konstrukční modely uvedené v této kapitole nebyly plně ověřeny v laboratorním testování Cisco kvůli velikosti a rozsahu testování, které by bylo nutné. Dvoustupňové modely, které jsou pokryty, jsou podobné návrhy, které byly implementovány do výrobních sítí zákazníků.

konstrukční modely uvedené v této kapitole nebyly plně ověřeny v laboratorním testování Cisco kvůli velikosti a rozsahu testování, které by bylo nutné. Dvoustupňové modely, které jsou pokryty, jsou podobné návrhy, které byly implementovány do výrobních sítí zákazníků.

technické cíle

při navrhování velké podnikové klastrové sítě je důležité zvážit konkrétní cíle. Žádné dva klastry nejsou přesně stejné; každý má své vlastní specifické požadavky a musí být zkoumán z hlediska aplikace, aby se určily konkrétní konstrukční požadavky. Vezměte v úvahu následující technické úvahy:

•![]() latence-v síťovém přenosu může latence nepříznivě ovlivnit celkový výkon clusteru. Použití přepínacích platforem, které používají architekturu přepínání s nízkou latencí, pomáhá zajistit optimální výkon. Hlavním zdrojem latence je protokol stack a implementace NIC hardware používané na serveru. Optimalizace ovladačů a techniky offload CPU, jako je TCP Offload Engine (TOE) a vzdálený přímý přístup do paměti (RDMA), mohou pomoci snížit latenci a snížit režii zpracování na serveru.

latence-v síťovém přenosu může latence nepříznivě ovlivnit celkový výkon clusteru. Použití přepínacích platforem, které používají architekturu přepínání s nízkou latencí, pomáhá zajistit optimální výkon. Hlavním zdrojem latence je protokol stack a implementace NIC hardware používané na serveru. Optimalizace ovladačů a techniky offload CPU, jako je TCP Offload Engine (TOE) a vzdálený přímý přístup do paměti (RDMA), mohou pomoci snížit latenci a snížit režii zpracování na serveru.

latence nemusí být vždy kritickým faktorem při návrhu clusteru. Například některé klastry mohou vyžadovat vysokou šířku pásma mezi servery kvůli velkému množství hromadného přenosu souborů, ale nemusí se spoléhat na zprávy mezi servery (IPC), které mohou být ovlivněny vysokou latencí.

•![]() Mesh / parcial mesh connectivity – návrhy clusteru serveru obvykle vyžadují síť nebo částečnou síťovinu umožňující komunikaci mezi všemi uzly v clusteru. Tato síťovina se používá ke sdílení stavu, dat a dalších informací mezi servery master-to-compute a compute-to-compute v clusteru. Síťová nebo částečná síťová konektivita je také závislá na aplikaci.

Mesh / parcial mesh connectivity – návrhy clusteru serveru obvykle vyžadují síť nebo částečnou síťovinu umožňující komunikaci mezi všemi uzly v clusteru. Tato síťovina se používá ke sdílení stavu, dat a dalších informací mezi servery master-to-compute a compute-to-compute v clusteru. Síťová nebo částečná síťová konektivita je také závislá na aplikaci.

•![]() vysoká propustnost-schopnost odeslat velký soubor v určitém čase může být rozhodující pro provoz a výkon clusteru. Serverové klastry obvykle vyžadují minimální množství dostupné neblokovací šířky pásma, což se promítá do modelu s nízkým nadměrným odběrem mezi přístupovou a jádrovou vrstvou.

vysoká propustnost-schopnost odeslat velký soubor v určitém čase může být rozhodující pro provoz a výkon clusteru. Serverové klastry obvykle vyžadují minimální množství dostupné neblokovací šířky pásma, což se promítá do modelu s nízkým nadměrným odběrem mezi přístupovou a jádrovou vrstvou.

•![]() poměr nadměrného odběru-poměr nadměrného odběru musí být zkoumán ve více agregačních bodech v návrhu, včetně linkové karty pro přepnutí šířky pásma tkaniny a vstupu tkaniny přepínače na šířku pásma uplinku.

poměr nadměrného odběru-poměr nadměrného odběru musí být zkoumán ve více agregačních bodech v návrhu, včetně linkové karty pro přepnutí šířky pásma tkaniny a vstupu tkaniny přepínače na šířku pásma uplinku.

•![]() podpora jumbo frame-ačkoli Jumbo frames nemusí být použity v počáteční implementaci clusteru serveru, je to velmi důležitá vlastnost, která je nezbytná pro další flexibilitu nebo pro možné budoucí požadavky. Konstrukce paketů TCP / IP klade další režii na CPU serveru. Použití jumbo snímků může snížit počet paketů, čímž se sníží tato režie.

podpora jumbo frame-ačkoli Jumbo frames nemusí být použity v počáteční implementaci clusteru serveru, je to velmi důležitá vlastnost, která je nezbytná pro další flexibilitu nebo pro možné budoucí požadavky. Konstrukce paketů TCP / IP klade další režii na CPU serveru. Použití jumbo snímků může snížit počet paketů, čímž se sníží tato režie.

•![]() hustota portů-clustery serverů mohou být nutné škálovat na desítky tisíc portů. Jako takové vyžadují platformy s vysokou úrovní výkonu přepínání paketů, velkým množstvím šířky pásma spínací tkaniny a vysokou hustotou portů.

hustota portů-clustery serverů mohou být nutné škálovat na desítky tisíc portů. Jako takové vyžadují platformy s vysokou úrovní výkonu přepínání paketů, velkým množstvím šířky pásma spínací tkaniny a vysokou hustotou portů.

distribuované předávání a latence

přepínač řady Cisco Catalyst 6500 má jedinečnou schopnost podporovat centrální předávání paketů nebo volitelnou architekturu distribuovaného předávání, zatímco Cisco Catalyst 4948-10GE je jediný centrální design ASIC s výkonem přesměrování pevných linek. Moduly linkové karty Cisco 6700 podporují volitelný modul dceřiné karty nazvaný Distributed Forwarding Card (DFC). DFC umožňuje místní rozhodnutí o směrování na každé linkové kartě implementací místní informační základny pro předávání (FIB). Tabulka FIB na Sup720 PFC udržuje synchronizaci s každou tabulkou DFC FIB na linkových kartách, aby byla zajištěna integrita směrování v celém systému.

pokud není k dispozici volitelná karta DFC, je na PFC3 na Sup720 odesláno kompaktní vyhledávání záhlaví, aby se určilo, kam na přepínací tkanině předat každý paket. Pokud je přítomen DFC, linka karta může přepnout paket přímo přes přepínací tkaninu na cílovou linkovou kartu bez konzultace s Sup720. Rozdíl ve výkonu může být od 30 Mpps v celém systému bez DFC do 48 Mpps na slot s DFC. Pevná konfigurace Catalyst 4948 – 10GE spínač má rychlost drátu, neblokující architekturu podporující až 101.18 Mpps výkon, poskytuje vynikající výkon přístupové vrstvy pro horní konstrukce stojanu.

výkon latence se může výrazně lišit při porovnání distribuovaných a centrálních modelů předávání. Tabulka 3-1 uvádí příklad latencí měřených přes linkovou kartu 6704 s DFC i bez ní.

| 6704 s DFC (Port-to-Port v mikrosekundách přes přepínací tkaninu) | ||||||||||

|---|---|---|---|---|---|---|---|---|---|---|

|

velikost paketu (B) |

||||||||||

|

latence (ms) |

||||||||||

| 6704 bez DFC (Port-to-Port v mikrosekundách přes přepínací tkaninu) | ||||||||||

|

velikost paketu (B) |

||||||||||

|

latence (ms) |

||||||||||

rozdíl v latenci mezi DFC povoleno a linková karta, která není povolena DFC, se nemusí jevit jako významná. V architektuře 6500 central forwarding se však latence může zvýšit se zvyšováním rychlosti provozu kvůli sporu o sdílené vyhledávání na centrální sběrnici. U DFC je vyhledávací cesta vyhrazena pro každou linkovou kartu a latence je konstantní.

Catalyst 6500 šířka pásma systému

dostupná šířka pásma systému se při použití DFC nemění. DFC zlepšují zpracování paketů za sekundu (pps) celkového systému. Tabulka 3-2 shrnuje výkon propustnosti a šířky pásma pro moduly, které podporují DFC, kromě starších modulů cef256 a classic bus.

| Konfigurace systému se Sup720 | propustností v Mpps | šířkou pásma v Gbps |

|

moduly řady Classic |

až 15 Mpps (na systém) |

16 G shared bus (klasický autobus) |

|

moduly řady CEF256 |

až 30 Mpps (na systém) |

1x 8 G (vyhrazeno na slot) |

|

směs classic s moduly řady CEF256 nebo Cef720 |

až 15 Mpps (na systém) |

závislé na kartě |

|

moduly řady CEF720(6748, 6704, 6724) |

až 30 Mpps (na systém) |

2x 20 G (vyhrazeno na slot) |

|

moduly řady CEF720 s DFC3 (6704 s DFC3, 6708 s DFC3, 6748 s DFC3 6724+DFC3) |

Sustain až 48 Mpps (na slot) |

2x 20 G (vyhrazeno na slot) |

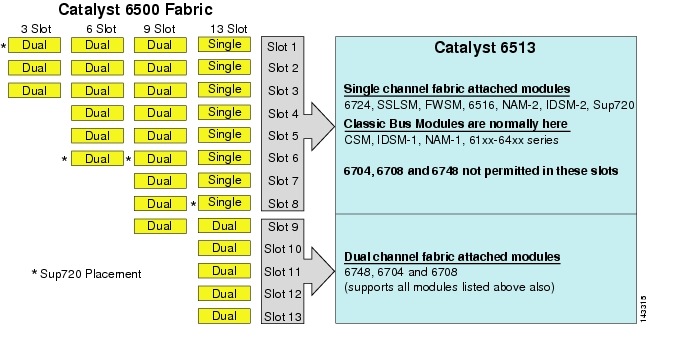

ačkoli 6513 může být platným řešením pro přístupovou vrstvu modelu velkého klastru, všimněte si, že v tomto podvozku je směs jednokanálových a dvoukanálových slotů. Sloty 1 na 8 jsou jednokanálové a sloty 9 na 13 jsou dvoukanálové, jak je znázorněno na obrázku 3-1.

figura 3-1 katalyzátor 6500 látkové kanály šasi a slotu (6513 zaostření

při použití Cisco Catalyst 6513, dvoukanálové karty, jako je 6704-4 port 10GigE, 6708 – 8 port 10GigE, a 6748-48 port SFP/měděné linky karty mohou být umístěny pouze v slotů 9 na 13. Jednokanálové linkové karty, jako jsou 6724-24 port SFP / měděné linkové karty, lze použít ve slotech 1 až 8. Sup720 používá sloty 7 a 8, které jsou připojeny k jednokanálové 20g tkanině. Na rozdíl od 6513 má 6509 méně dostupných slotů, ale může podporovat dvoukanálové moduly ve všech slotech, protože každý slot má dvojité kanály k přepínací tkanině.

Poznámka ![]() protože prostředí clusteru serverů obvykle vyžaduje vysokou šířku pásma s nízkou latencí, doporučujeme v těchto typech návrhů použít DFC.

protože prostředí clusteru serverů obvykle vyžaduje vysokou šířku pásma s nízkou latencí, doporučujeme v těchto typech návrhů použít DFC.

Equal Cost Multi-Path Routing

Equal cost multi-path (ECMP) routing je technologie vyrovnávání zátěže, která optimalizuje toky napříč více IP cestami mezi libovolnými dvěma podsítěmi v prostředí Cisco Express Forwarding. ECMP používá vyvažování zátěže pro pakety TCP a UDP na základě průtoku. Pakety bez TCP/UDP, jako je ICMP, jsou distribuovány na základě paketů po paketech. ECMP je založen na RFC 2991 a je využíván na jiných platformách Cisco, jako jsou produkty Pix a Cisco Content Services Switch (CSS). ECMP je podporován na platformách 6500 a 4948-10GE doporučených v návrhu clusteru serverů.

dramatické změny vyplývající z Layer 3 přepínání hardwaru ASIC a Cisco Express Forwarding hashovací algoritmy pomáhá odlišit ECMP od svých předchůdců technologií. Hlavní výhodou v návrhu ECMP pro implementaci clusteru serverů je hashovací algoritmus kombinovaný s malou nebo žádnou režií procesoru při přepínání vrstvy 3. Hashovací algoritmus Cisco Express Forwarding je schopen distribuovat granulární toky přes více linkových karet rychlostí linky v hardwaru. Hashovací algoritmus výchozí nastavení je hash toky založené na Layer 3 zdroj-cíl IP adresy, a případně přidání čísla portů Layer 4 pro další vrstvu diferenciace. Maximální povolený počet cest ECMP je osm.

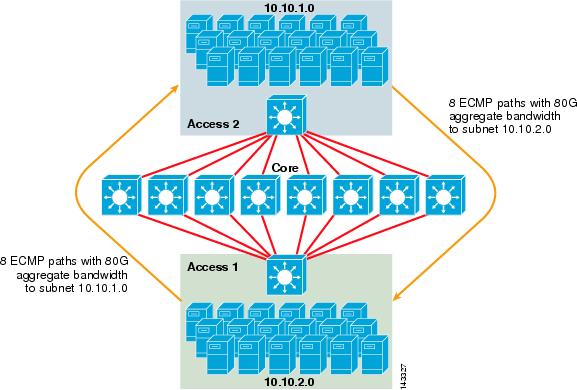

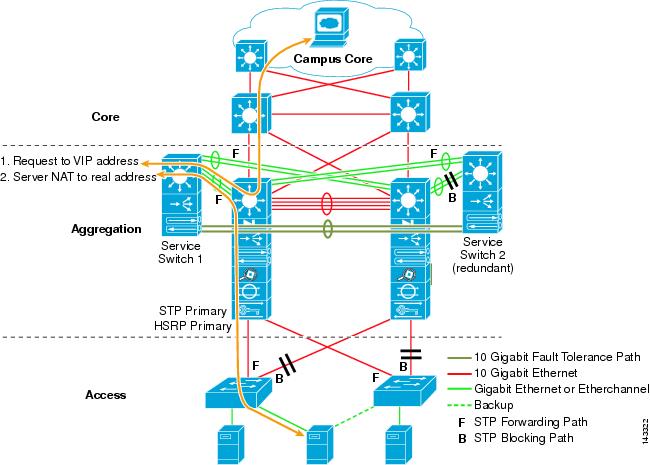

obrázek 3-2 ilustruje 8cestný návrh clusteru serveru ECMP. Pro zjednodušení obrázku jsou zobrazeny pouze dva přepínače přístupové vrstvy, ale lze podporovat až 32 (64 10GigEs na uzel jádra).

obrázek 3-2 8cestný návrh clusteru serveru ECMP

na obrázku 3-2 může každý přepínač přístupové vrstvy podporovat jednu nebo více podsítí připojených serverů. Každý přepínač má jeden 10gige připojení ke každému z osmi jádrových přepínačů pomocí dvou 6704 linkové karty. Tato konfigurace poskytuje osm cest 10GigE v celkové výši 80 g Cisco Express Forwarding povoleno šířku pásma do jakékoliv jiné podsítě v clusteru serveru tkaniny. Dotaz na trasu show ip do jiné podsítě na jiném přepínači zobrazuje osm položek se stejnou cenou.

jádro je naplněno 10gige linkovými kartami s DFC, které umožňují plně distribuovanou vysokorychlostní spínací tkaninu s velmi nízkou latencí portu na port. Dotaz show ip route k přepínači přístupové vrstvy zobrazuje jednu položku trasy na každém z osmi hlavních přepínačů.

Poznámka ![]() ačkoli to nebylo testováno pro tuto příručku, existuje nový 8portový 10 Gigabitový ethernetový modul (WS-X6708-10G-3C), který byl nedávno představen pro přepínač řady Catalyst 6500. Tato řádková karta bude testována na zařazení do této příručky později. Dotazy týkající se karty 8-port 10GigE naleznete v datovém listu produktu.

ačkoli to nebylo testováno pro tuto příručku, existuje nový 8portový 10 Gigabitový ethernetový modul (WS-X6708-10G-3C), který byl nedávno představen pro přepínač řady Catalyst 6500. Tato řádková karta bude testována na zařazení do této příručky později. Dotazy týkající se karty 8-port 10GigE naleznete v datovém listu produktu.

redundance v návrhu clusteru serveru

návrh clusteru serveru obvykle není implementován s redundantními procesory CPU nebo switch fabric. Odolnost je obvykle dosaženo neodmyslitelně v návrhu a metodou clusteru funguje jako celek. Jak je popsáno v kapitole 1 „Přehled architektury datových Center“, výpočetní uzly v klastru jsou spravovány hlavními uzly, které jsou odpovědné za přiřazení konkrétních úloh každému výpočetnímu uzlu a sledování jejich výkonu. Pokud výpočetní uzel vypadne z clusteru, přeřadí se na dostupný uzel a pokračuje v činnosti, i když s menším výpočetním výkonem, dokud není uzel k dispozici. I když je důležité diverzifikovat připojení hlavního uzlu v clusteru přes různé přístupové přepínače, není to pro výpočetní uzly kritické.

ačkoli redundantní procesory jsou jistě volitelné, je důležité zvážit hustotu portů, zejména s ohledem na porty 10GE, kde je místo redundantního modulu Sup720 k dispozici další slot.

Poznámka ![]() příklady v této kapitole používají neredundantní návrhy CPU, které umožňují maximálně 64 10GE portů na 6509 jádrový uzel dostupný pro připojení uplinku přístupového uzlu na základě použití 6708 8portové 10gige linkové karty.

příklady v této kapitole používají neredundantní návrhy CPU, které umožňují maximálně 64 10GE portů na 6509 jádrový uzel dostupný pro připojení uplinku přístupového uzlu na základě použití 6708 8portové 10gige linkové karty.

návrh clusteru serveru-dvoustupňový Model

tato část popisuje různé přístupy návrhu clusteru serveru, který využívá ECMP a distribuovaný CEF. Každý návrh ukazuje, jak různé konfigurace mohou dosáhnout různých úrovní nadměrného odběru a mohou flexibilně škálovat, počínaje několika uzly a rostoucími na mnoho, které podporují tisíce serverů.

návrh clusteru serveru se obvykle řídí dvoustupňovým modelem sestávajícím z jádrových a přístupových vrstev. Protože cíle návrhu vyžadují použití vrstvy 3 ECMP a distribuované předávání k dosažení vysoce deterministické šířky pásma a latence na server, třístupňový model, který zavádí další bod nadměrné nabídky, obvykle není žádoucí. Výhody třístupňového modelu jsou popsány v návrhu clusteru serverů-třístupňový Model.

tři hlavní výpočty, které je třeba zvážit při navrhování řešení clusteru serverů, jsou maximální připojení k serveru, šířka pásma na server a poměr nadměrného odběru. Návrháři clusteru mohou tyto hodnoty určit na základě výkonu aplikace, hardwaru serveru a dalších faktorů, včetně následujících:

•![]() maximální počet připojení GigE serveru v měřítku-návrháři klastrů mají obvykle představu o maximálním měřítku požadovaném při počátečním konceptu. Výhodou funkce ECMP designs je, že mohou začít s minimálním počtem přepínačů a serverů, které splňují konkrétní požadavky na šířku pásma, latenci a nadměrnou odběr, a flexibilně rostou nízkým/nerušivým způsobem v maximálním měřítku při zachování stejné šířky pásma, latence a nadměrných hodnot.

maximální počet připojení GigE serveru v měřítku-návrháři klastrů mají obvykle představu o maximálním měřítku požadovaném při počátečním konceptu. Výhodou funkce ECMP designs je, že mohou začít s minimálním počtem přepínačů a serverů, které splňují konkrétní požadavky na šířku pásma, latenci a nadměrnou odběr, a flexibilně rostou nízkým/nerušivým způsobem v maximálním měřítku při zachování stejné šířky pásma, latence a nadměrných hodnot.

•![]() přibližná šířka pásma na server-tuto hodnotu lze určit pouhým vydělením celkové agregované šířky pásma uplinku celkovým připojením serveru GigE na přepínači přístupové vrstvy. Například přístupová vrstva Cisco 6509 se čtyřmi 10gige ecmp uplinky s 336 přístupové porty serveru lze vypočítat následovně:

přibližná šířka pásma na server-tuto hodnotu lze určit pouhým vydělením celkové agregované šířky pásma uplinku celkovým připojením serveru GigE na přepínači přístupové vrstvy. Například přístupová vrstva Cisco 6509 se čtyřmi 10gige ecmp uplinky s 336 přístupové porty serveru lze vypočítat následovně:

4x10GigE uplinky s 336 servery = 120 Mbps na server

nastavení obou stranách rovnice snižuje nebo zvyšuje množství šířky pásma na server.

Poznámka ![]() Toto je pouze přibližná hodnota a slouží pouze jako vodítko. Skutečné množství šířky pásma, které má každý server k dispozici, ovlivňují různé faktory. Algoritmus hash distribuce zatížení ECMP rozděluje zatížení na základě hodnot vrstvy 3 plus vrstvy 4 a liší se v závislosti na vzorcích provozu. Také konfigurační parametry, jako je omezení rychlosti, fronty a hodnoty QoS, mohou ovlivnit skutečnou dosaženou šířku pásma na server.

Toto je pouze přibližná hodnota a slouží pouze jako vodítko. Skutečné množství šířky pásma, které má každý server k dispozici, ovlivňují různé faktory. Algoritmus hash distribuce zatížení ECMP rozděluje zatížení na základě hodnot vrstvy 3 plus vrstvy 4 a liší se v závislosti na vzorcích provozu. Také konfigurační parametry, jako je omezení rychlosti, fronty a hodnoty QoS, mohou ovlivnit skutečnou dosaženou šířku pásma na server.

•![]() Oversubscription ratio per server-tuto hodnotu lze určit pouhým vydělením celkového počtu připojení GigE serveru celkovou agregovanou šířkou pásma uplinku na přepínači přístupové vrstvy. Například, přístupová vrstva 6509 se čtyřmi 10gige ecmp uplinks s 336 přístupových portů serveru lze vypočítat takto:

Oversubscription ratio per server-tuto hodnotu lze určit pouhým vydělením celkového počtu připojení GigE serveru celkovou agregovanou šířkou pásma uplinku na přepínači přístupové vrstvy. Například, přístupová vrstva 6509 se čtyřmi 10gige ecmp uplinks s 336 přístupových portů serveru lze vypočítat takto:

336 GigE připojení serveru s 40g uplink šířka pásma = 8.4: 1 oversubscription ratio

následující oddíly ukazují, jak se tyto hodnoty liší, na základě různých konfigurací hardwaru a propojení, a slouží jako vodítko při navrhování velkých konfigurací clusteru.

Poznámka ![]() pro účely výpočtu se předpokládá, že na přepínači řady Catalyst 6500 není žádná linková karta pro přepínání přepisu tkaniny. Dvoukanálový slot poskytuje 40G maximální šířku pásma k přepínací tkanině. 4-port 10gige Karta se všemi porty při rychlosti linky s použitím maximální velikost paketů je považován za nejlepší možný stav s malou nebo žádnou nadměrnou odběr. Skutečné množství přepínače tkaniny šířky pásma k dispozici se liší, na základě průměrných velikostí paketů. Tyto výpočty by musely být přepočítány, pokud byste měli použít kartu WS-X6708 8-port 10GigE, která je přepsána na 2: 1.

pro účely výpočtu se předpokládá, že na přepínači řady Catalyst 6500 není žádná linková karta pro přepínání přepisu tkaniny. Dvoukanálový slot poskytuje 40G maximální šířku pásma k přepínací tkanině. 4-port 10gige Karta se všemi porty při rychlosti linky s použitím maximální velikost paketů je považován za nejlepší možný stav s malou nebo žádnou nadměrnou odběr. Skutečné množství přepínače tkaniny šířky pásma k dispozici se liší, na základě průměrných velikostí paketů. Tyto výpočty by musely být přepočítány, pokud byste měli použít kartu WS-X6708 8-port 10GigE, která je přepsána na 2: 1.

4-a 8-cestné návrhy ECMP s modulárním přístupem

následující čtyři příklady návrhu demonstrují různé metody vytváření a škálování dvoustupňového modelu clusteru serverů pomocí 4-cestného a 8-cestného ECMP. Hlavní problémy, které je třeba zvážit, jsou počet základních uzlů a maximální počet uplinků, protože tyto přímo ovlivňují maximální měřítko, šířku pásma na server a hodnoty nadměrného odběru.

Poznámka ![]() ačkoli to nebylo testováno pro tuto příručku, existuje nový 8portový 10 Gigabitový ethernetový modul (WS-X6708-10G-3C), který byl nedávno představen pro přepínač řady Catalyst 6500. Tato řádková karta bude testována na zařazení do průvodce později. Dotazy týkající se karty 8-port 10GigE naleznete v datovém listu produktu.

ačkoli to nebylo testováno pro tuto příručku, existuje nový 8portový 10 Gigabitový ethernetový modul (WS-X6708-10G-3C), který byl nedávno představen pro přepínač řady Catalyst 6500. Tato řádková karta bude testována na zařazení do průvodce později. Dotazy týkající se karty 8-port 10GigE naleznete v datovém listu produktu.

Poznámka ![]() odkazy nezbytné pro připojení clusteru serveru k vnější síti kampusu nebo metra nejsou v těchto příkladech návrhu uvedeny, ale měly by být zváženy.

odkazy nezbytné pro připojení clusteru serveru k vnější síti kampusu nebo metra nejsou v těchto příkladech návrhu uvedeny, ale měly by být zváženy.

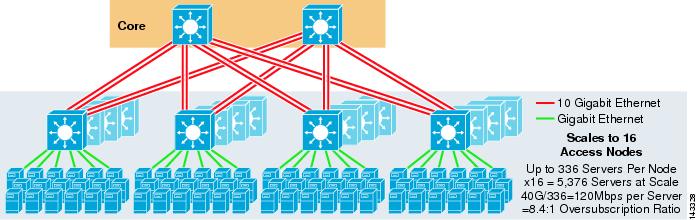

obrázek 3-3 poskytuje příklad, ve kterém jsou dva jádrové uzly použity k poskytnutí 4cestného řešení ECMP.

obrázek 3-3 4CESTNÝ ECMP využívající dva jádrové uzly

výhodou tohoto přístupu je, že menší počet jádrových přepínačů může podporovat velké množství serverů. Možnou nevýhodou je vysoký přepis-nízká šířka pásma na hodnotu serveru a velká expozice selhání jádra uzlu. Všimněte si, že uplinky jsou jednotlivé L3 uplinky a nejsou EtherChannels.

obrázek 3-4 ukazuje, jak přidání dvou jádrových uzlů k předchozímu návrhu může dramaticky zvýšit maximální měřítko při zachování stejných hodnot nadměrného odběru a šířky pásma na server.

obrázek 3-4 4cestný ECMP využívající čtyři jádrové uzly

obrázek 3-5 ukazuje 8cestný ECMP návrh využívající dva jádrové uzly.

obrázek 3-5 8CESTNÝ ECMP pomocí dvou jádrových uzlů

podle očekávání dodatečná šířka pásma uplinku dramaticky zvyšuje šířku pásma na server a snižuje poměr nadměrného odběru na server. Všimněte si, jak další sloty pořízené v každém přepínači přístupové vrstvy pro podporu 8cestných uplinků snižují maximální měřítko, protože počet serverů na přepínač je snížen na 288. Všimněte si, že uplinky jsou jednotlivé L3 uplinky a nejsou EtherChannels.

obrázek 3-6 ukazuje 8cestný návrh ECMP s osmi jádrovými uzly.

obrázek 3-6 8CESTNÝ ECMP pomocí osmi jádrových uzlů

to ukazuje, jak přidání čtyř jádrových uzlů ke stejnému předchozímu návrhu může dramaticky zvýšit maximální měřítko při zachování stejných hodnot nadměrné nabídky a šířky pásma na server.

2-Way ECMP Design s přístupem 1RU

v mnoha prostředích clusteru je přepínání serverů založených na racku pomocí malých přepínačů v horní části každého serverového stojanu žádoucí nebo vyžadováno z důvodu kabeláže,administrativy, problémů s nemovitostmi nebo splnění konkrétních cílů modelu nasazení.

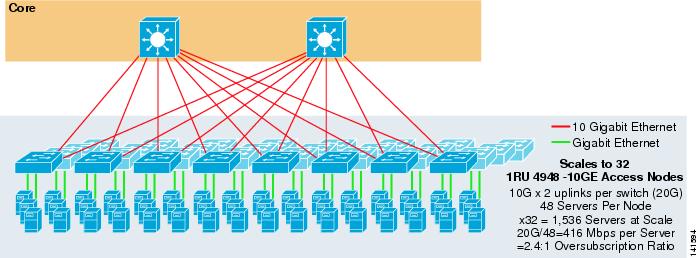

obrázek 3-7 ukazuje příklad, ve kterém jsou dva jádrové uzly použity k poskytnutí 2cestného řešení ECMP s přístupovými přepínači 1RU 4948-10GE.

obrázek 3-7 2cestný ECMP využívající dva jádrové uzly a přístup 1RU

maximální měřítko je omezeno na 1536 serverů, ale poskytuje více než 400 Mbps šířky pásma s nízkým poměrem nadměrného odběru. Vzhledem k tomu, 4948 má pouze dva 10gige uplinky, tento návrh nemůže měřítko nad rámec těchto hodnot.

Poznámka ![]() více informací o přepínání rackových serverů je uvedeno v kapitole 3 “ návrhy clusterů serverů s Ethernetem.“

více informací o přepínání rackových serverů je uvedeno v kapitole 3 “ návrhy clusterů serverů s Ethernetem.“

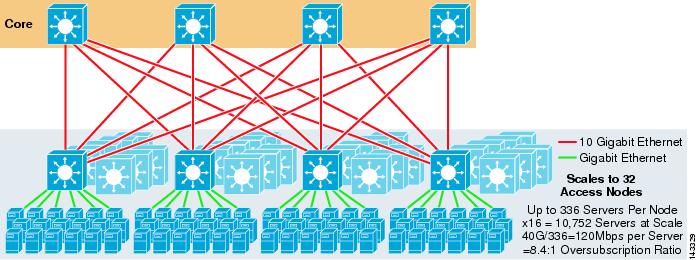

návrh clusteru serverů-třívrstvý Model

ačkoli je dvouvrstvý model nejběžnější u velkých clusterových návrhů, lze také použít třívrstvý model. Třístupňový model se obvykle používá k podpoře implementací clusteru velkých serverů pomocí přepínačů 1RU nebo modulárních přístupových vrstev.

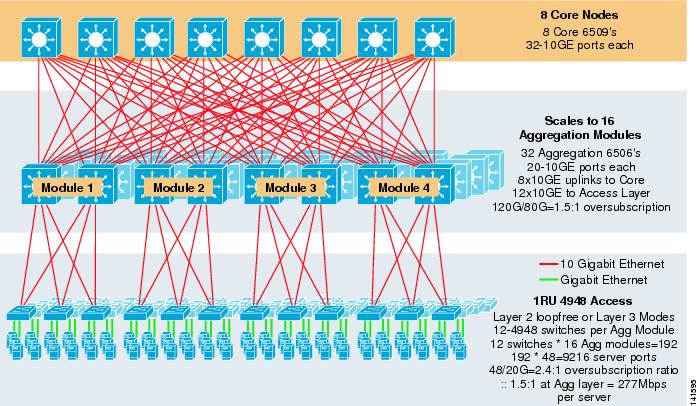

obrázek 3-8 ukazuje příklad ve velkém měřítku využívající 8cestný ECMP s 6500 jádrovými a agregačními přepínači a 1RU 4948-10GE přepínači přístupové vrstvy.

obrázek 3-8 třístupňový Model s 8CESTNÝM ECMP

maximální měřítko je přes 9200 serverů s šířkou pásma 277 Mbps s nízkým poměrem nadměrného odběru. Výhody třístupňového přístupu pomocí přístupových přepínačů 1RU zahrnují následující:

•![]() 1RU deployment models – jak již bylo zmíněno, mnoho velkých nasazení clusterových modelů vyžaduje pro zjednodušenou instalaci přístup 1RU. Například ASP zavádí regály serverů najednou, když škálují velké clusterové aplikace. Serverový stojan je předem sestaven a uspořádán mimo pracoviště tak, aby mohl být rychle nainstalován a přidán do spuštěného clusteru. To obvykle zahrnuje třetí stranu, která staví regály, předkonfiguruje servery, a předběžně je propojí s napájením a Ethernetem k přepínači 1RU. Rack se valí do datového centra a po připojení uplinků se jednoduše zapojí a přidá do clusteru.

1RU deployment models – jak již bylo zmíněno, mnoho velkých nasazení clusterových modelů vyžaduje pro zjednodušenou instalaci přístup 1RU. Například ASP zavádí regály serverů najednou, když škálují velké clusterové aplikace. Serverový stojan je předem sestaven a uspořádán mimo pracoviště tak, aby mohl být rychle nainstalován a přidán do spuštěného clusteru. To obvykle zahrnuje třetí stranu, která staví regály, předkonfiguruje servery, a předběžně je propojí s napájením a Ethernetem k přepínači 1RU. Rack se valí do datového centra a po připojení uplinků se jednoduše zapojí a přidá do clusteru.

bez agregační vrstvy je maximální velikost přístupového modelu 1RU omezena na více než 1500 serverů. Přidání agregační vrstvy umožňuje modelu 1RU access škálovat na mnohem větší velikost a přitom stále využívat model ECMP.

•![]() centralizace jádrových a agregačních spínačů – s 1RU spínači rozmístěnými v regálech je možné centralizovat větší jádrové a agregační modulární spínače. To může zjednodušit infrastrukturu napájení a kabeláže a zlepšit využití rackových nemovitostí.

centralizace jádrových a agregačních spínačů – s 1RU spínači rozmístěnými v regálech je možné centralizovat větší jádrové a agregační modulární spínače. To může zjednodušit infrastrukturu napájení a kabeláže a zlepšit využití rackových nemovitostí.

•![]() umožňuje topologii bez smyčky vrstvy 2-velká klastrová síť využívající přístup Ecmp vrstvy 3 může na uplincích používat mnoho adresního prostoru a může přidat složitost návrhu. To je zvláště důležité, pokud se používá veřejný adresní prostor. Přístup třístupňového modelu se dobře hodí k topologii přístupu bez smyčky vrstvy 2, která snižuje počet požadovaných podsítí.

umožňuje topologii bez smyčky vrstvy 2-velká klastrová síť využívající přístup Ecmp vrstvy 3 může na uplincích používat mnoho adresního prostoru a může přidat složitost návrhu. To je zvláště důležité, pokud se používá veřejný adresní prostor. Přístup třístupňového modelu se dobře hodí k topologii přístupu bez smyčky vrstvy 2, která snižuje počet požadovaných podsítí.

pokud je použit model bez smyček vrstvy 2, je důležité použít redundantní výchozí protokol brány, jako je HSRP nebo GLBP, k odstranění jediného bodu selhání, pokud selže agregační uzel. V tomto návrhu nejsou agregační moduly vzájemně propojeny, což umožňuje návrh vrstvy 2 bez smyčky, který může využít GLBP pro automatické vyvažování zátěže brány serveru. GLBP automaticky distribuuje servery výchozí přiřazení brány mezi dvěma uzly v agregačním modulu. Poté, co paket dorazí na agregační vrstvu, je vyvážen přes jádro pomocí 8cestné ECMP tkaniny. Ačkoli GLBP neposkytuje hash rozložení zatížení vrstvy 3 / vrstvy 4 podobný CEF, jedná se o alternativu, kterou lze použít s topologií přístupu vrstvy 2.

výpočet nadměrného odběru

třívrstvý model zavádí dva body nadměrného odběru v přístupových a agregačních vrstvách ve srovnání s dvouvrstvým modelem, který má pouze jeden bod nadměrného odběru v přístupové vrstvě. Chcete-li správně vypočítat přibližnou šířku pásma na server a poměr nadměrného odběru, proveďte následující dva kroky, které jako příklad použijí obrázek 3-8:

Krok 1 ![]() Vypočítejte poměr nadměrného odběru a šířku pásma na server pro agregační i přístupové vrstvy nezávisle.

Vypočítejte poměr nadměrného odběru a šířku pásma na server pro agregační i přístupové vrstvy nezávisle.

•![]() přístupová vrstva

přístupová vrstva

–![]() Oversubscription – 48ge připojené servery / 20g uplinky k agregaci = 2.4:1

Oversubscription – 48ge připojené servery / 20g uplinky k agregaci = 2.4:1

–![]() šířka pásma na server – 20g uplinky k agregaci / 48gige připojené servery = 416Mbps

šířka pásma na server – 20g uplinky k agregaci / 48gige připojené servery = 416Mbps

•![]() agregační vrstva

agregační vrstva

–![]() Oversubscription-120G downlinks to access / 80G uplinks to core = 1.5:1

Oversubscription-120G downlinks to access / 80G uplinks to core = 1.5:1

Krok 2 ![]() Vypočítejte kombinovaný poměr nadměrného odběru a šířku pásma na server.

Vypočítejte kombinovaný poměr nadměrného odběru a šířku pásma na server.

skutečný poměr nadměrného odběru je součtem dvou bodů nadměrného odběru v přístupové a agregační vrstvě.

1.5*2.4 = 3.6:1

pro určení skutečné šířky pásma na hodnotu serveru použijte algebraický vzorec pro proporce:

a: b = c: d

šířka pásma na server v přístupové vrstvě byla stanovena na 416 Mbps na server. Vzhledem k tomu, agregační vrstva oversubscription poměr je 1,5: 1, můžete použít výše uvedený vzorec takto:

416:1 = x: 1.5

x= ~ 264 Mbps na server

doporučený Hardware a moduly

doporučené platformy pro návrh modelu clusteru serverů se skládají z rodiny Cisco Catalyst 6500 S procesorovým modulem Sup720 a přepínačem Catalyst 4948-10GE 1RU. Vysoká spínací rychlost, velký přepínač tkanina, nízká latence, distribuované předávání, a 10gige hustota činí Catalyst 6500 přepínač série ideální pro všechny vrstvy tohoto modelu. Tvarový faktor 1RU v kombinaci s přeposíláním rychlosti drátu, uplinkováním 10GE a velmi nízkou konstantní latencí činí z 4948-10GE vynikající řešení pro přístupovou vrstvu.

doporučuje se následující:

•![]() Sup720-Sup720 se může skládat jak z PFC3A (výchozí), tak z novějších dceřiných karet typu PFC3B.

Sup720-Sup720 se může skládat jak z PFC3A (výchozí), tak z novějších dceřiných karet typu PFC3B.

•![]() linkové karty-Všechny linkové karty by měly být řady 6700 a měly by být povoleny pro distribuované předávání s dceřinými kartami DFC3A nebo DFC3B.

linkové karty-Všechny linkové karty by měly být řady 6700 a měly by být povoleny pro distribuované předávání s dceřinými kartami DFC3A nebo DFC3B.

Poznámka ![]() použitím všech modulů řady cef720 připojených k tkanině je globální spínací režim kompaktní, což umožňuje systému pracovat na nejvyšší úrovni výkonu. Catalyst 6509 může podporovat 10 GigE moduly ve všech polohách, protože každý slot podporuje duální kanály k přepínači tkaniny (Cisco Catalyst 6513 nepodporuje toto).

použitím všech modulů řady cef720 připojených k tkanině je globální spínací režim kompaktní, což umožňuje systému pracovat na nejvyšší úrovni výkonu. Catalyst 6509 může podporovat 10 GigE moduly ve všech polohách, protože každý slot podporuje duální kanály k přepínači tkaniny (Cisco Catalyst 6513 nepodporuje toto).

•![]() Cisco Catalyst 4948-10GE-4948-10GE poskytuje vysoce výkonné řešení přístupové vrstvy, která může využít ECMP a 10gige uplinky. Nejsou nutné žádné zvláštní požadavky. Den 4948-10GE lze použít vrstvu 2 Cisco IOS image nebo vrstva 2/3 Cisco IOS image, umožňující optimální fit v obou prostředí.

Cisco Catalyst 4948-10GE-4948-10GE poskytuje vysoce výkonné řešení přístupové vrstvy, která může využít ECMP a 10gige uplinky. Nejsou nutné žádné zvláštní požadavky. Den 4948-10GE lze použít vrstvu 2 Cisco IOS image nebo vrstva 2/3 Cisco IOS image, umožňující optimální fit v obou prostředí.