Hur du analyserar dina A / B-testresultat med Google Analytics

A/B-testverktyg som Optimizely eller VWO gör testningen enkel, och det handlar om det. De är verktyg för att köra tester, och inte exakt utformade för analys efter test. De flesta testverktyg har blivit bättre på det genom åren, men saknar fortfarande vad du kan göra med Google Analytics – vilket är som allt.

när du kör ett test tills du har nått giltighet (inte samma sak som betydelse) måste du göra analys efter testet för att bestämma vägen framåt.

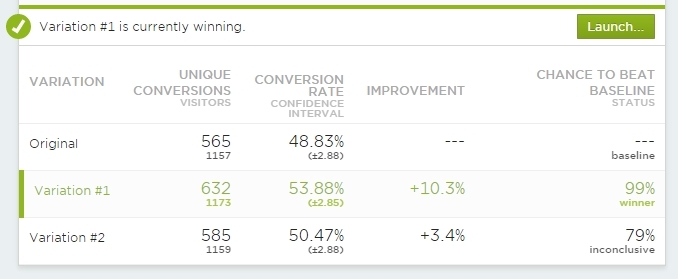

att titta på en sammanfattningsskärm som denna räcker inte:

Använd dessa at-a-glace vyer för en snabb kontroll för att se vad den totala statusen är. Men du måste gå längre än när testet är”kokt”.

ditt test kan egentligen bara sluta på 3 olika sätt:

- kontroll vinner

- ingen skillnad

- behandling (er) vinna (er)

även när vårt testverktyg säger att det är det slutliga resultatet, det är inte där vårt jobb slutar. Du måste genomföra analys efter test. Och i de flesta fall måste du göra det utanför testverktyget. Sure-Optimizely gör att du kan se resultaten över fördefinierade segment, men det räcker inte heller.

du måste integrera varje test med Google Analytics

både VWO och Optimizely kommer med inbyggda Google Analytics-integrationer, och data för varje test ska skickas till Google Analytics. Det är inte bara för att förbättra dina analysfunktioner, men också för att vara mer säker på data. Ditt testverktyg kan spela in data felaktigt, och om du inte har någon annan källa för dina testdata kan du aldrig vara säker på om du ska lita på det eller inte. Skapa flera datakällor.

7 sätt som prediktiv analys omvandlar e-handel

av Gagan Mehra

prediktiv analys hjälper dig att förstå vad dina kunder ska köpa innan de gör det.

Optimizely Classic

i Optimizely Classic ställa in integrationen är under Projektinställningar:

du vill definitivt använda Universal Analytics istället för klassisk Google Analytics. Om du inte har bytt GA tracker över ännu, gör det så snart du kan.

inte bara kommer du att kunna dra nytta av nya GA-funktioner, Du kan ha upp till 20 samtidiga A/B-tester som skickar data till Google Analytics. Med Classic är det bara 5.

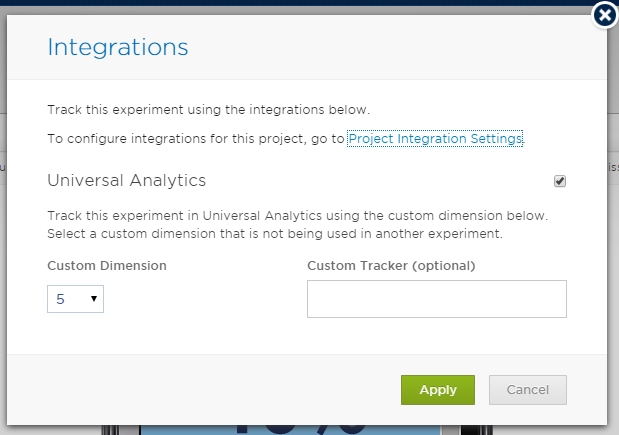

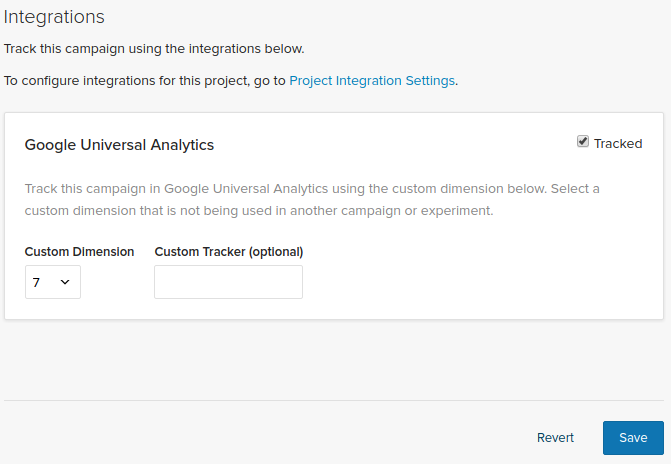

och när detta är gjort på global nivå måste du välja en plats för varje test:

se till att det inte finns flera tester som använder samma anpassade Dimension (eller anpassad variabel för klassisk) slot i GA – de kommer att skriva över varandras data, och du kan inte lita på det längre. Ett test per slits.

Optimizelys manual har en steg-för-steg-instruktion för denna integration också, inklusive hur man ställer in anpassade dimensioner.

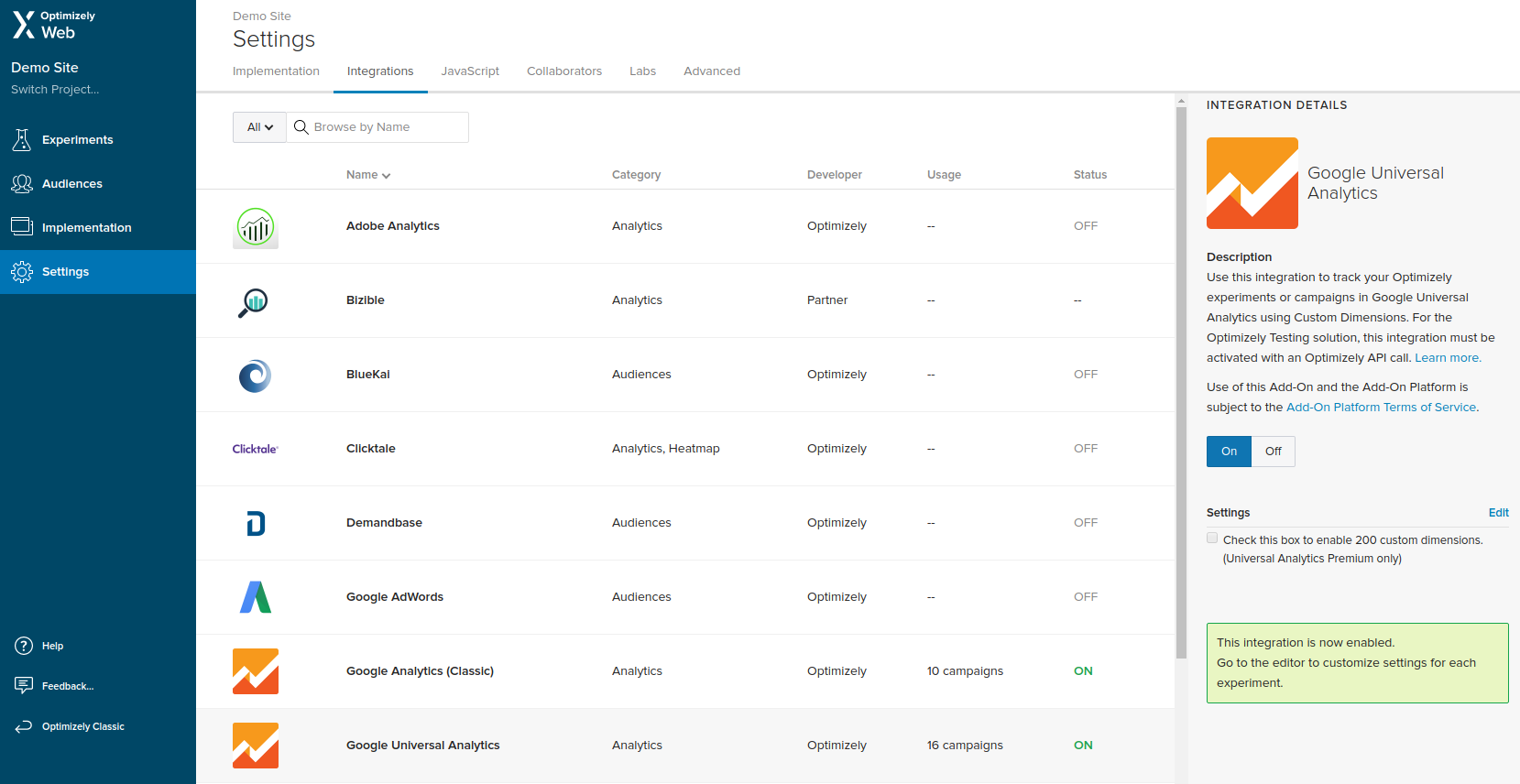

Optimizely X

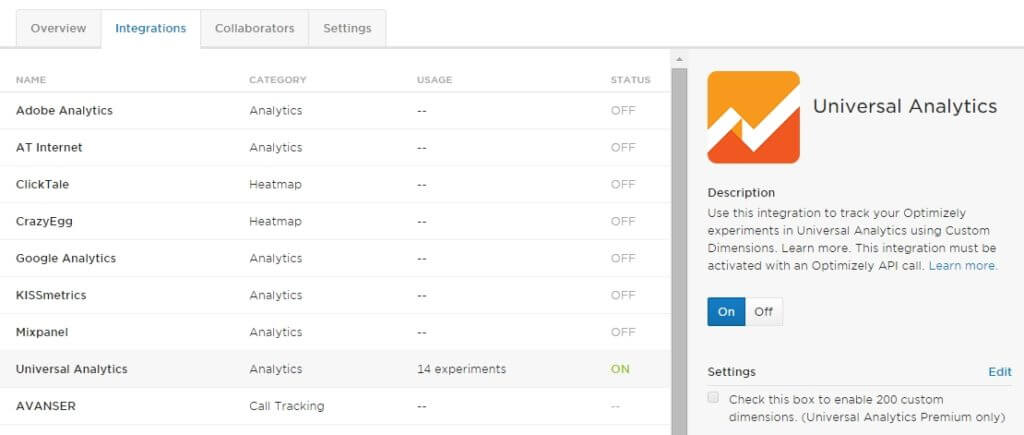

i Optimizely X måste du gå till Inställningar och navigera till integrationer, där kan du hitta Google Universal Analytics, slå på den.

när du har aktiverat integrationen på projektnivå måste du också aktivera den för varje experiment genom att välja platsen (anpassad Dimension).

precis som med Optimizely Classic bör du aldrig välja samma plats för två tester som körs samtidigt.

för detaljerad information om hur du får integrationen igång, inklusive att skapa anpassade dimensioner i Google Analytics, ta en titt på guiden på deras webbplats.

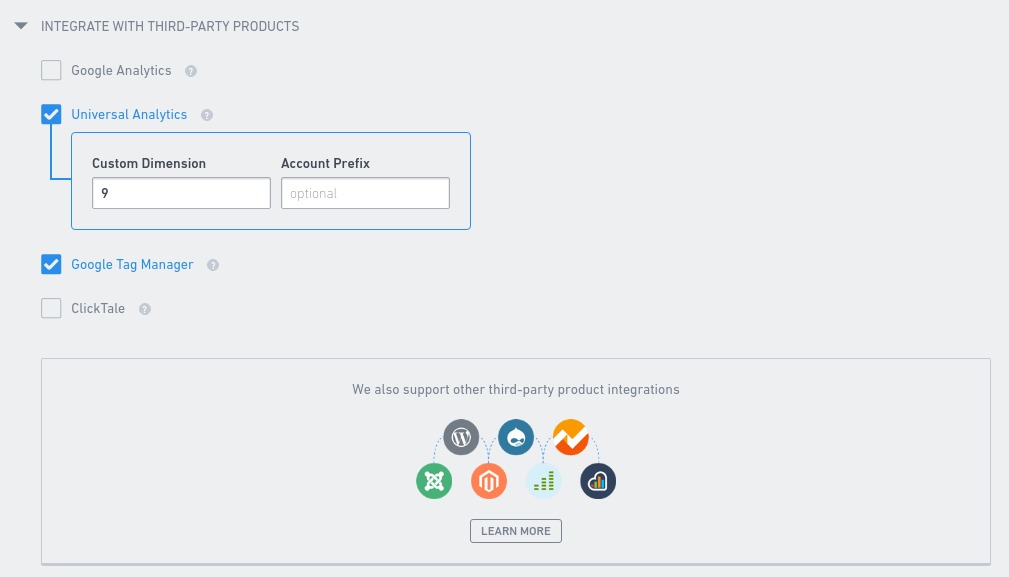

VWO

när det gäller att integrera Google Analytics med dina vwo-experiment behöver du bara välja rätt anpassad Dimension på fliken andra i Experimentinställningar. Detta måste göras med varje experiment.

som med Optimizely, ett aktivt experiment per anpassad Dimension. Annars riskerar du att skriva över några av testdata som lagras i Google Analytics.

mer information om integrationen finns i en artikel i vwos knowledge base.

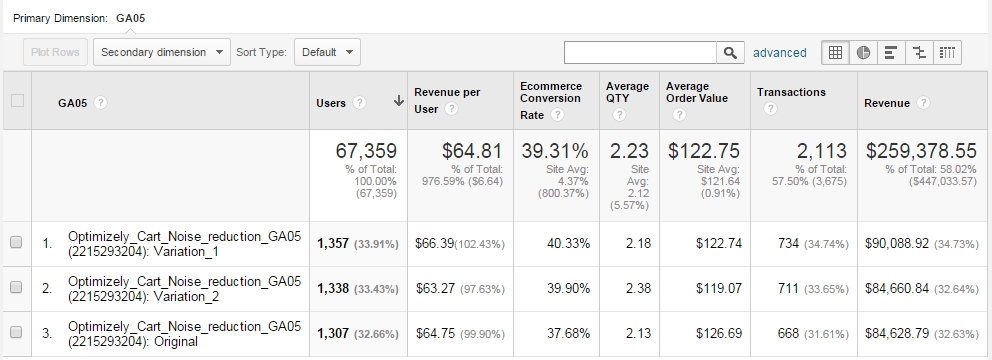

åtkomst till experimentdata i Google Analytics

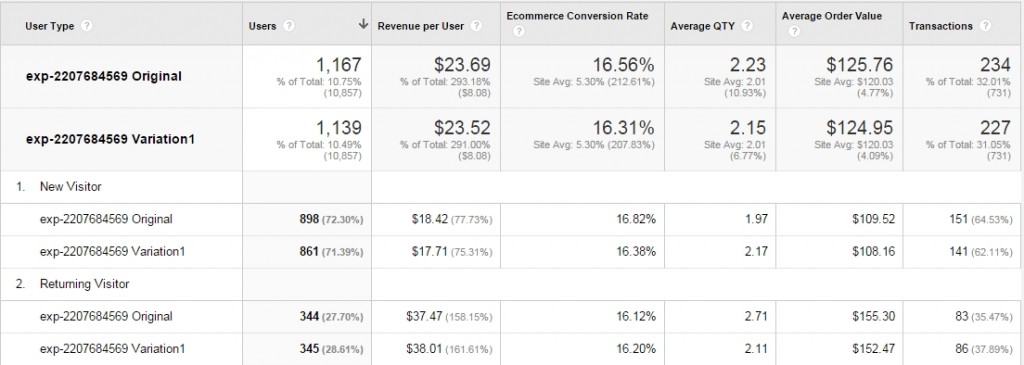

när du är klar kan du titta på alla testresultat i Google Analytics med anpassade rapporter. Du kan få rapporten Att visa alla data du vill ha:

någon variation har mer intäkter per användare? Varför är det – låt oss titta på genomsnittligt vagnvärde eller genomsnittlig kvantitet-dessa mätvärden kan kasta lite ljus här.

Använd alla mätvärden som är användbara i ditt specifika fall. Svep den anpassade rapporten som används i exemplet här.

Observera att Google Analytics inte kommer att berätta något om statistisk signifikans (p-värden), effektnivåer, felmarginaler och så vidare. Du skulle behöva dra den data till ett Excel / Google-kalkylblad eller något där du automatiskt beräknar det. Börja inte analysen I GA innan data är kokta. Se till att den nödvändiga provstorleken och signifikansen + effektnivåerna finns där.

skicka variationer som händelser för att använda avancerade segment (målgrupper)

inbyggd Google Analytics-integration är inte idiotsäker. Ibland överförs inte data, det finns en skillnad på 20% till 50% – någonstans på något sätt går en del av data vilse. Det kan finnas många orsaker till det, allt från hur skripten laddas, i vilken ordning till skripttidsavbrott och andra problem. Jag har hanterat många olika problem genom åren.

min goda vän Ton Wesseling berättade först om den här lösningen: skicka en händelse till Google Analytics varje gång en variation laddas.

allt du behöver göra är att lägga till en rad i test Global Javascript (exekverad för alla variationer), plus en rad händelsespårningskod som sista raden för varje testvariation.

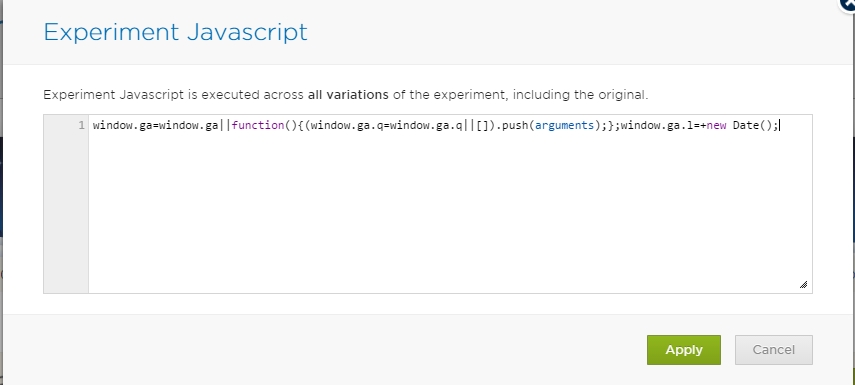

så det här är raden Du bör lägga till i den globala Experiment Javascript-konsolen:

window.ga=window.ga||function(){(window.ga.q=window.ga.q||).push(arguments);};window.ga.l=+new Date();

Detta säkerställer att GA tracker får all information när den laddas.

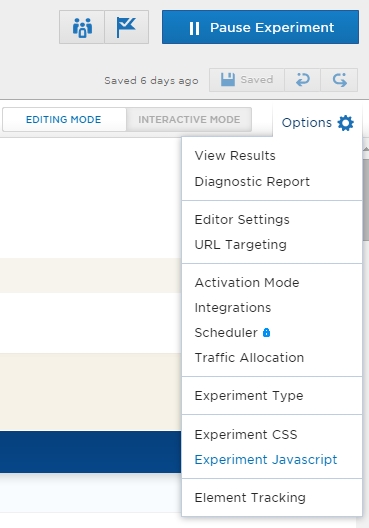

här är där du gör det i Optimizely. Öppna först inställningarna medan du redigerar ett test:

och välj nu Experiment Javascript. Lägg till koden där:

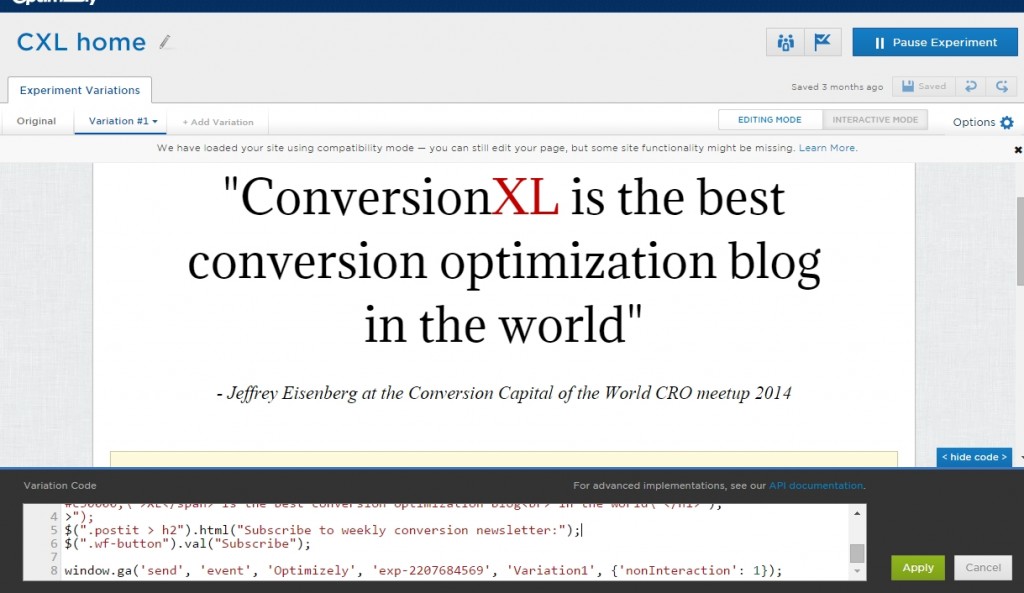

och nu måste du lägga till en rad händelsespårningskod i slutet av varje variation (inklusive Original). Du behöver bara ändra experimentets ID-nummer och namnet på variationen:

window.ga('send', 'event', 'Optimizely', 'exp-2207684569', 'Variation1', {'nonInteraction': 1});

så vad koden gör är att skicka en händelse till GA där händelsekategorin är Optimizely, åtgärd är Experiment ID (Du kan få det från din URL när du redigerar ett test) och etiketten är Variation1 (kan också vara Original, Variation 2 etc). Icke-interaktion innebär att inget engagemang registreras. Annars skulle din avvisningsfrekvens för experimentsidor vara 0%.

här lägger du till koden i Optimizely:

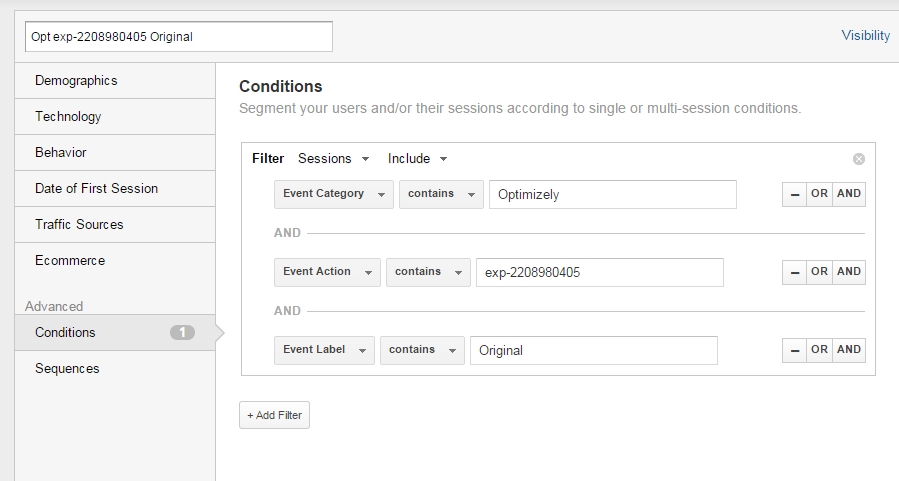

nu kan du skapa segment i Google Analytics för var och en av variationerna.

Segmentinställning:

skapa separata segment för varje variant och tillämpa dem på vilken rapport du vill. Så du kunde se något så här:

endast illustrativa uppgifter.

samma sak kan naturligtvis göras med anpassade dimensioner. Se bara till att datakonsistensen finns där-jämför tack sidbesök, intäktsnummer etc mellan din Optimizely resultatpanel och ga anpassad dimension eller händelsebaserad rapport”.

ingen skillnad mellan testvariationer. Vad händer nu?

låt oss säga att det övergripande resultatet är ’ingen signifikant skillnad’ mellan variationer. Gå vidare till något annat? Inte så fort. Håll dessa 2 saker i åtanke:

1. Din testhypotes kan ha varit rätt, men implementeringen suger

låt oss säga att din kvalitativa forskning säger att oro för säkerhet är ett problem. Hur många sätt måste vi stärka uppfattningen om säkerhet? Obegränsad.

du kan vara på något – precis som du gjorde något sög. Om du har data som stöder din hypotes, prova några fler iterationer.

2. Bara för att det inte fanns någon skillnad totalt sett kan behandlingen ha beat control i ett segment eller två.

om du har en hiss i återkommande besökare och mobila besökare, men en droppe för nya besökare och stationära användare – kan dessa segment avbryta varandra, och det verkar som om det är ett fall av ”ingen skillnad”. Analysera ditt test över viktiga segment för att se detta.

titta på testresultaten åtminstone över dessa segment (se till att varje segment har tillräcklig provstorlek):

- Desktop vs Tablet/Mobile

- Ny vs återvändande

- trafik som landar direkt på sidan du testar vs kom via intern länk

om din behandling fungerade bra för ett specifikt segment är det dags att överväga en personlig inställning för det specifika segmentet.

det är ingen skillnad, men du gillar B bättre än A

vi är människor, och vi har personliga preferenser. Så om ditt test säger att det inte finns någon signifikant skillnad mellan variationer, men du gillar B bättre – det finns verkligen ingen anledning att inte gå med B.

om B är en användbarhet förbättring eller representerar ditt varumärke bättre, gå för det. Men det är inte bra skäl att gå med B om B presterar sämre i ett test.

slutsats

lita inte på en enda datakälla och gå djupare med din analys än att bara titta på övergripande resultat. Du hittar fler vinster och har bättre data för att fatta beslut. Att integrera ditt testverktyg med Google Analytics är ett utmärkt sätt att göra det.

(detta inlägg uppdaterades väsentligt September 2017)

gå med i 95 000+ analytiker, optimerare, digitala marknadsförare och UX-utövare på vår lista

e-postmeddelanden en eller två gånger i veckan om tillväxt och optimering.