So analysieren Sie Ihre A / B-Testergebnisse mit Google Analytics

A / B-Testtools wie Optimizely oder VWO erleichtern das Testen. Sie sind Tools zum Ausführen von Tests und nicht genau für die Analyse nach dem Test konzipiert. Die meisten Testtools sind im Laufe der Jahre besser geworden, aber es fehlt immer noch das, was Sie mit Google Analytics tun können – was wie alles ist.

Wenn Sie einen Test ausführen, bis Sie die Gültigkeit erreicht haben (nicht dasselbe wie die Signifikanz), müssen Sie nach dem Test eine Analyse durchführen, um über den weiteren Weg zu entscheiden.

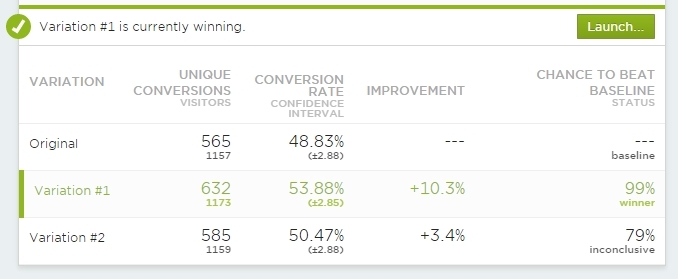

Das Betrachten eines solchen Zusammenfassungsbildschirms reicht nicht aus:

Verwenden Sie diese at-a-glace Ansichten für eine schnelle Überprüfung, um zu sehen, was der Gesamtstatus ist. Aber Sie müssen darüber hinausgehen, sobald der Test „gekocht“ ist.

Ihr Test kann wirklich nur auf 3 verschiedene Arten enden:

- Kontrolle gewinnt

- Kein Unterschied

- Behandlung(en) gewinnt(en)

Selbst wenn unser Testtool uns sagt, dass dies das Endergebnis ist, endet unsere Arbeit nicht dort. Sie müssen eine Analyse nach dem Test durchführen. Und in den meisten Fällen müssen Sie dies AUßERHALB des Testtools tun. Sicher – Mit Optimizely können Sie die Ergebnisse in vordefinierten Segmenten anzeigen, aber das reicht auch nicht aus.

Sie müssen jeden Test in Google Analytics integrieren

Sowohl VWO als auch Optimizely verfügen über integrierte Google Analytics-Integrationen, und die Daten für jeden Test sollten an Google Analytics gesendet werden. Es geht nicht nur darum, Ihre Analysefunktionen zu verbessern, sondern auch mehr Vertrauen in die Daten zu haben. Ihr Testtool zeichnet die Daten möglicherweise falsch auf, und wenn Sie keine andere Quelle für Ihre Testdaten haben, können Sie nie sicher sein, ob Sie ihr vertrauen sollen oder nicht. Erstellen Sie mehrere Datenquellen.

7 Möglichkeiten, wie Predictive Analytics den E-Commerce verändert

Von Gagan Mehra

Predictive Analytics hilft Ihnen zu verstehen, was Ihre Kunden kaufen werden, bevor sie es tun.

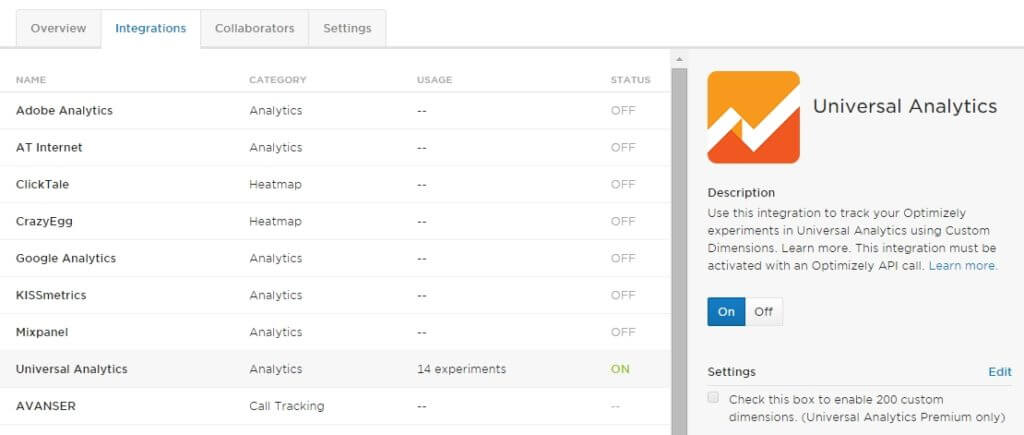

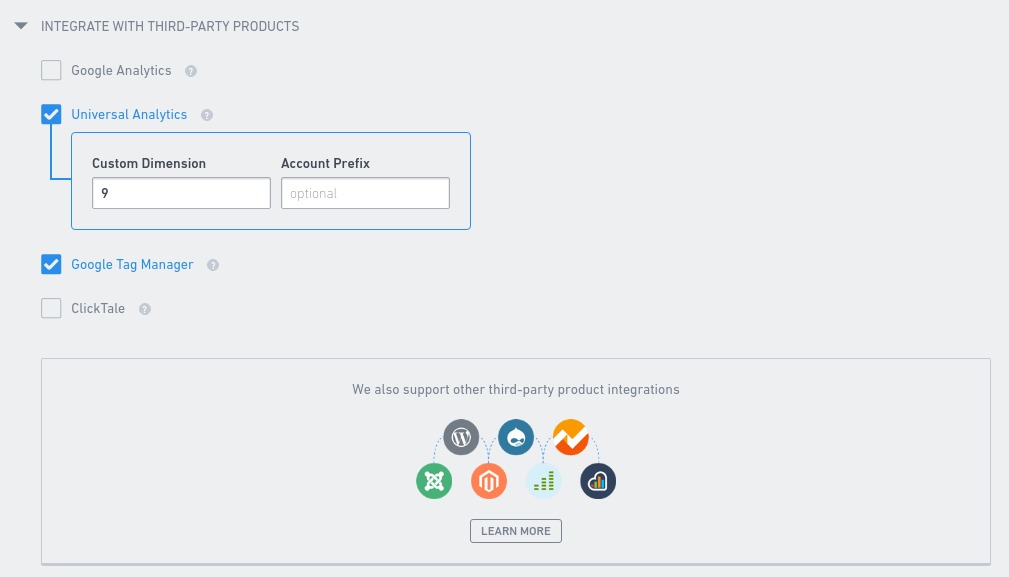

Optimizely Classic

Bei der Einrichtung von Optimizely Classic befindet sich die Integration unter Projekteinstellungen:

Sie möchten auf jeden Fall Universal Analytics anstelle von klassischem Google Analytics verwenden. Wenn Sie Ihren GA-Tracker noch nicht umgestellt haben, tun Sie dies so schnell wie möglich.

Sie können nicht nur die neuen GA-Funktionen nutzen, sondern auch bis zu 20 gleichzeitige A / B-Tests durchführen, um Daten an Google Analytics zu senden. Mit Classic sind es nur 5.

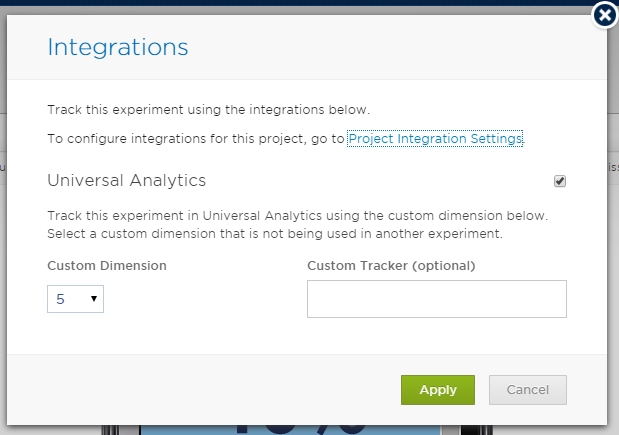

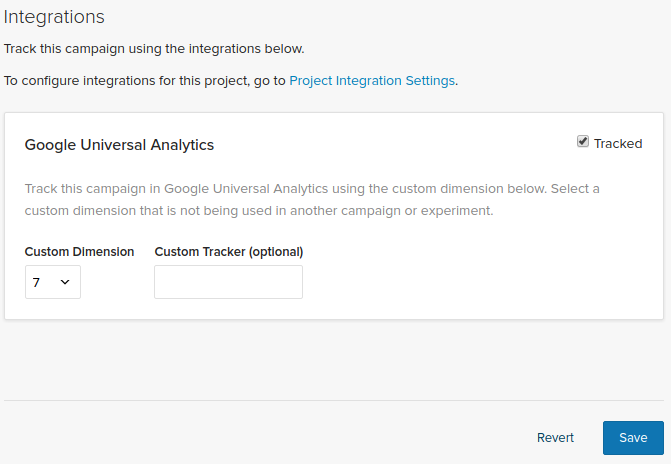

Und sobald dies auf globaler Ebene erfolgt ist, müssen Sie für jeden Test einen Slot auswählen:

Stellen Sie sicher, dass es in GA nicht mehrere Tests gibt, die dieselbe benutzerdefinierte Dimension (oder benutzerdefinierte Variable für Classic) verwenden. Ein Test pro Steckplatz.

Das Handbuch von Optimizely enthält auch eine Schritt-für-Schritt-Anleitung für diese Integration, einschließlich der Einrichtung benutzerdefinierter Dimensionen.

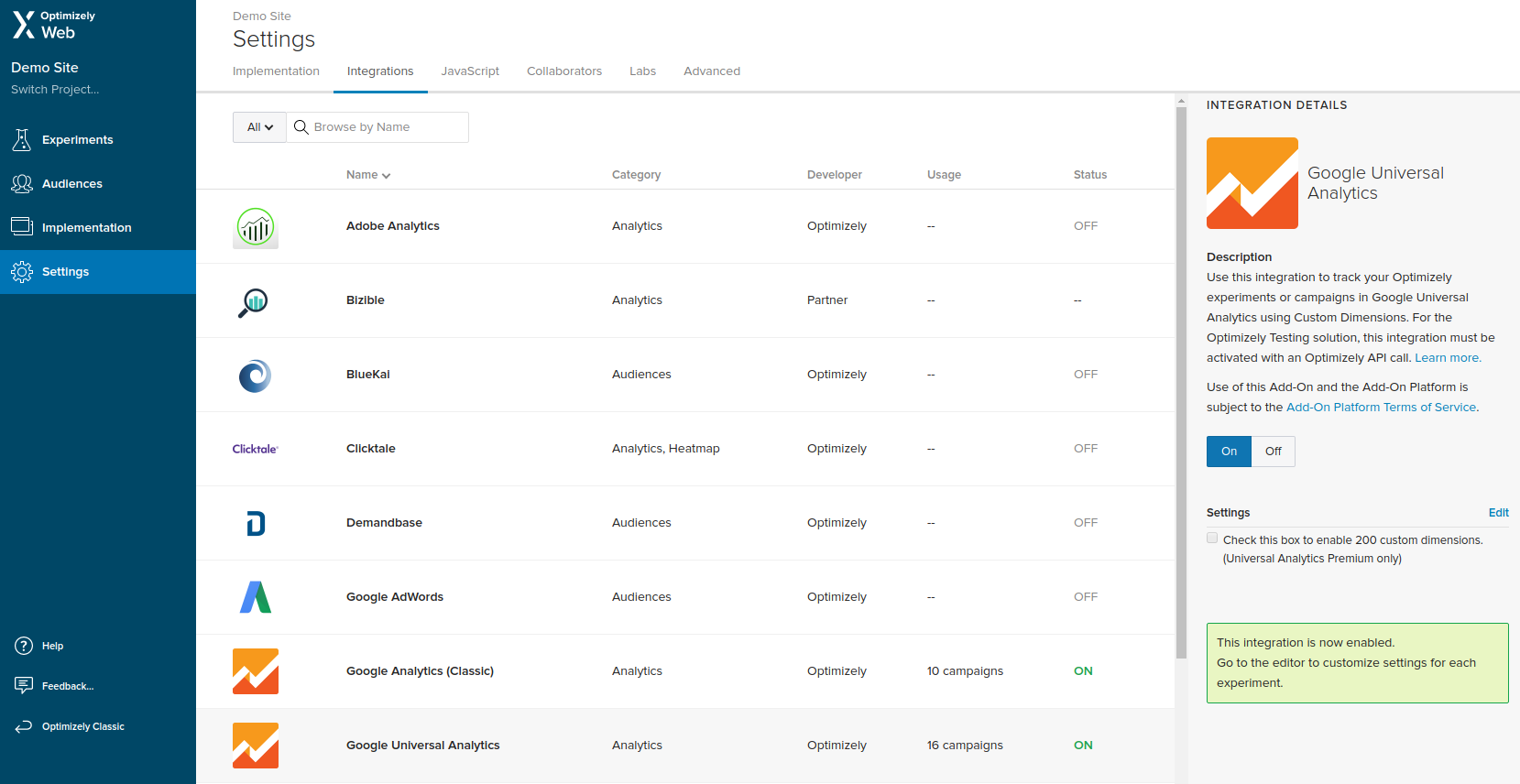

Optimizely X

In Optimizely X müssen Sie zu Einstellungen gehen und zu Integrationen navigieren.

Sobald Sie die Integration auf Projektebene aktiviert haben, müssen Sie sie auch für jedes Experiment aktivieren, indem Sie den Slot (Benutzerdefinierte Dimension) auswählen.

Genau wie bei Optimizely Classic sollten Sie niemals denselben Slot für zwei Tests auswählen, die gleichzeitig ausgeführt werden.

Detaillierte Informationen zum Ausführen der Integration, einschließlich zum Erstellen der benutzerdefinierten Dimensionen in Google Analytics, finden Sie im Handbuch auf ihrer Website.

VWO

Wenn Sie Google Analytics in Ihre VWO-Experimente integrieren möchten, müssen Sie nur die richtige benutzerdefinierte Dimension auf der Registerkarte Andere der Experimenteinstellungen auswählen. Das muss bei jedem Experiment gemacht werden.

Wie bei Optimizely ein aktives Experiment pro benutzerdefinierter Dimension. Andernfalls riskieren Sie, einige der in Google Analytics gespeicherten Testdaten zu überschreiben.

Weitere Informationen zur Integration finden Sie in einem Artikel in der VWO Knowledge Base.

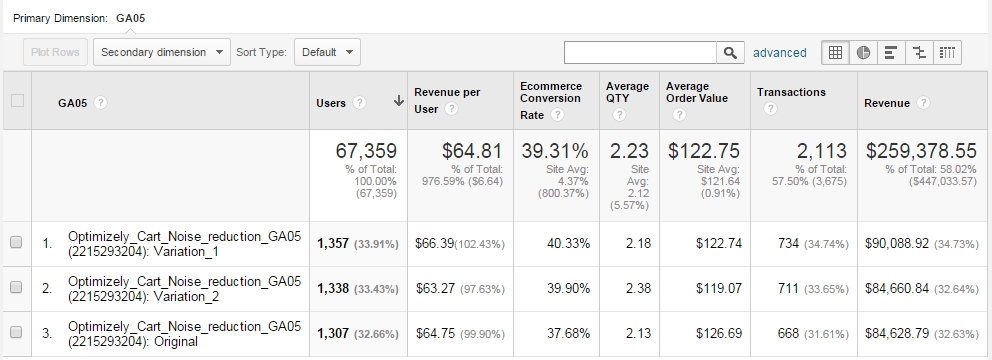

Zugriff auf Experimentdaten in Google Analytics

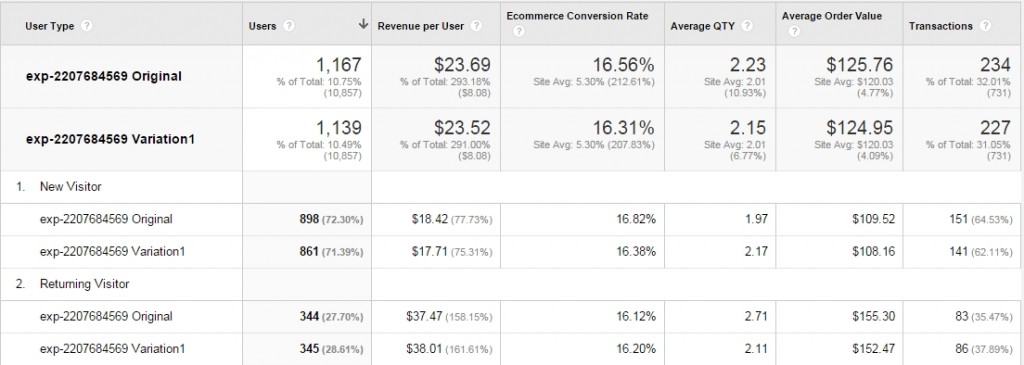

Sobald Sie fertig sind, können Sie jedes Testergebnis in Google Analytics mithilfe benutzerdefinierter Berichte anzeigen. Sie können den Bericht ALLE gewünschten Daten anzeigen lassen:

Eine Variante hat mehr Umsatz pro Benutzer? Warum ist das so – schauen wir uns den durchschnittlichen Warenkorbwert oder die durchschnittliche Menge an – diese Metriken können hier etwas Licht ins Dunkel bringen.

Verwenden Sie alle Metriken, die in Ihrem speziellen Fall nützlich sind. Wählen Sie den benutzerdefinierten Bericht aus, der im Beispiel hier verwendet wird.

Beachten Sie, dass Google Analytics Ihnen nichts über statistische Signifikanz (p-Werte), Leistungsstufen, Fehlermargen usw. sagt. Sie müssten diese Daten in eine Excel / Google-Tabelle oder etwas ziehen, wo Sie das automatisch berechnen. Starten Sie die Analyse nicht in GA, bevor die Daten gekocht sind. Stellen Sie sicher, dass die erforderliche Stichprobengröße und Signifikanz + Leistungsstufen vorhanden sind.

Senden Sie Variationen als Ereignisse, um erweiterte Segmente (Zielgruppen) zu verwenden

Die integrierte Google Analytics-Integration ist nicht narrensicher. Manchmal werden die Daten nicht weitergegeben, es gibt eine Diskrepanz von 20% bis 50% – irgendwo geht irgendwie ein Teil der Daten verloren. Dafür kann es zahlreiche Gründe geben, von der Art und Weise, wie die Skripte geladen werden, in welcher Reihenfolge bis hin zu Skript-Timeouts und anderen Problemen. Ich habe im Laufe der Jahre mit vielen verschiedenen Problemen zu tun gehabt.

Mein guter Freund Ton Wesseling hat mir zuerst von dieser Problemumgehung erzählt: Senden Sie jedes Mal, wenn eine Variation geladen wird, ein Ereignis an Google Analytics.

Sie müssen lediglich eine Zeile zum globalen Test-Javascript hinzufügen (ausgeführt für alle Variationen) sowie eine Zeile Ereignisverfolgungscode als letzte Zeile für jede Testvariante.

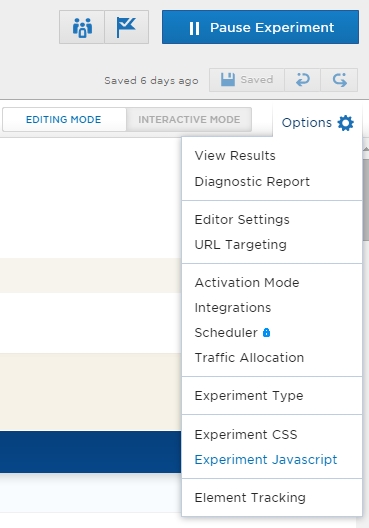

Dies ist also die Zeile, die Sie in der globalen Experiment-Javascript-Konsole hinzufügen sollten:

window.ga=window.ga||function(){(window.ga.q=window.ga.q||).push(arguments);};window.ga.l=+new Date();

Dadurch wird sichergestellt, dass der GA-Tracker alle Informationen erhält, sobald er geladen ist.

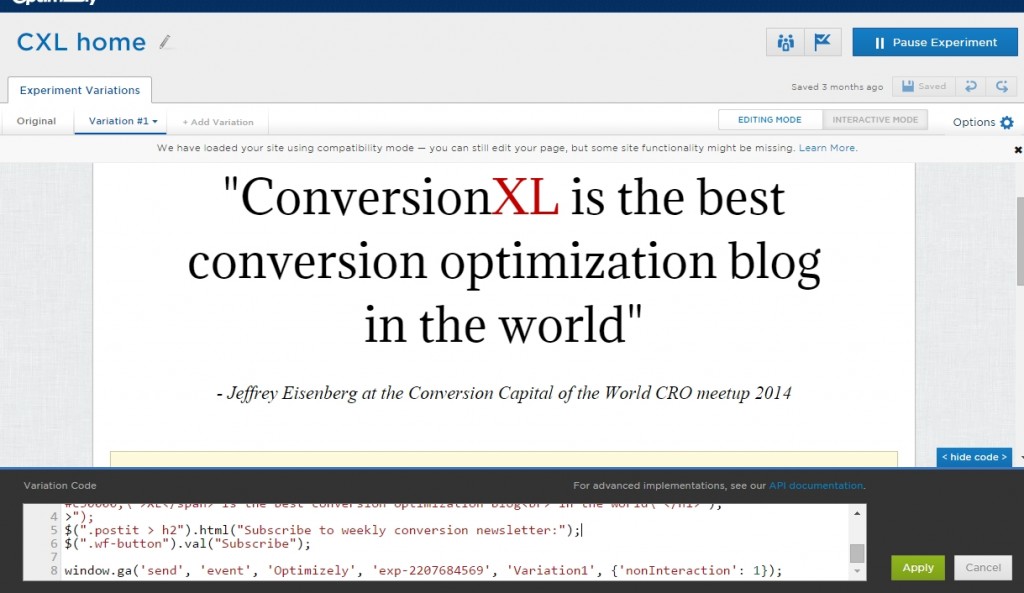

Hier ist, wo Sie es in Optimizely tun. Öffnen Sie zuerst die Einstellungen, während Sie einen Test bearbeiten:

Und jetzt wähle Experiment Javascript. Fügen Sie den Code dort hinzu:

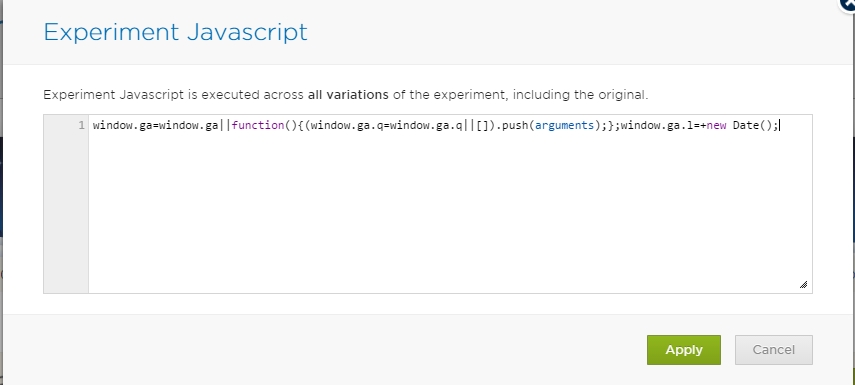

Und jetzt müssen Sie am Ende jeder Variation (einschließlich Original) eine Zeile Ereignisverfolgungscode hinzufügen. Sie müssen nur die Experiment-ID-Nummer und den Namen der Variation ändern:

window.ga('send', 'event', 'Optimizely', 'exp-2207684569', 'Variation1', {'nonInteraction': 1});

Der Code sendet also ein Ereignis an GA, bei dem die Ereigniskategorie Optimizely , die Aktion die Experiment-ID (die Sie während der Bearbeitung eines Tests von Ihrer URL abrufen können) und das Label Variation1 (kann auch Original, Variation 2 usw. sein). Nicht-Interaktion bedeutet, dass kein Engagement aufgezeichnet wird. Andernfalls wäre Ihre Absprungrate für Experimentseiten 0%.

Hier fügen Sie den Code in Optimizely hinzu:

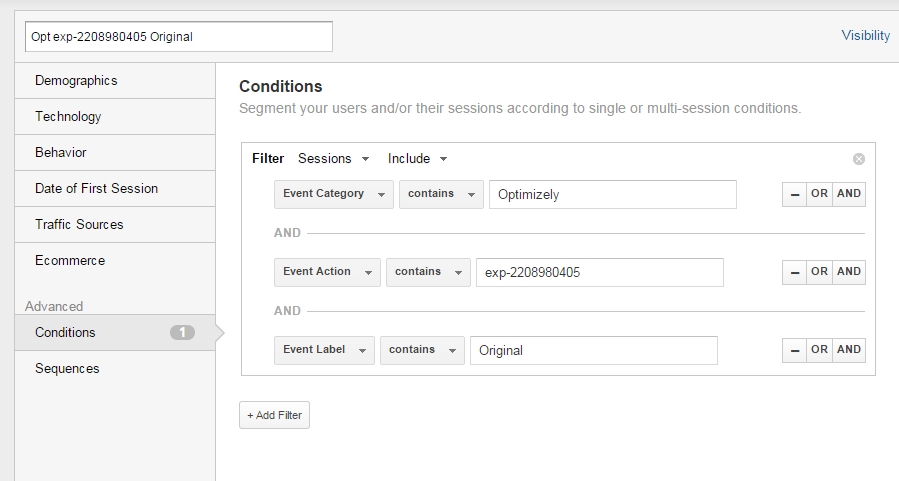

Jetzt können Sie Segmente in Google Analytics für jede der Varianten erstellen.

Segment einrichten:

Erstellen Sie separate Segmente für jede Variation und wenden Sie sie auf jeden gewünschten Bericht an. So könnte man so etwas sehen:

Nur illustrative Daten.

Dasselbe kann natürlich auch mit benutzerdefinierten Abmessungen gemacht werden. Stellen Sie einfach sicher, dass die Datenkonsistenz vorhanden ist – vergleichen Sie Dankesseitenbesuche, Umsatzzahlen usw. zwischen Ihrem Optimizely-Ergebnispanel und GA benutzerdefinierte Dimension oder ereignisbasierter Bericht „.

Kein Unterschied zwischen Testvariationen. Was nun?

Nehmen wir an, das Gesamtergebnis ist ‚kein signifikanter Unterschied‘ zwischen den Variationen. Weiter zu etwas anderem? Nicht so schnell. Beachten Sie diese 2 Dinge:

1. Ihre Testhypothese mag richtig gewesen sein, aber die Implementierung von

Nehmen wir an, Ihre qualitative Forschung besagt, dass Bedenken hinsichtlich der Sicherheit ein Problem darstellen. Wie viele Möglichkeiten haben wir, die Wahrnehmung von Sicherheit zu verbessern? Unbegrenzt.

Sie könnten an etwas dran sein – genau so, wie Sie etwas falsch gemacht haben. Wenn Sie Daten haben, die Ihre Hypothese unterstützen, versuchen Sie es mit einigen weiteren Iterationen.

2. Nur weil es insgesamt keinen Unterschied gab, könnte die Behandlung in einem oder zwei Segmenten die Kontrolle verloren haben.

Wenn Sie bei wiederkehrenden Besuchern und mobilen Besuchern einen Anstieg, bei neuen Besuchern und Desktop–Benutzern jedoch einen Rückgang verzeichnen, können sich diese Segmente gegenseitig aufheben, und es scheint, als ob es sich um „keinen Unterschied“ handelt. Analysieren Sie Ihren Test über Schlüsselsegmente hinweg, um dies zu sehen.

Sehen Sie sich die Testergebnisse zumindest in diesen Segmenten an (stellen Sie sicher, dass jedes Segment über eine ausreichende Stichprobengröße verfügt):

- Desktop vs Tablet / Mobile

- Neu vs Zurück

- Traffic, der direkt auf der Seite landet, die Sie testen vs kam über internen Link

Wenn Ihre Behandlung für ein bestimmtes Segment gut abschneidet, ist es an der Zeit, einen personalisierten Ansatz für dieses bestimmte Segment in Betracht zu ziehen.

Es gibt keinen Unterschied, aber Sie mögen B besser als A

Wir sind Menschen und haben persönliche Vorlieben. Also, wenn Ihr Test sagt, dass es keinen signifikanten Unterschied zwischen Variationen gibt, aber Sie mögen B besser – es gibt wirklich keinen Grund, nicht mit B zu gehen.

Wenn B eine Verbesserung der Benutzerfreundlichkeit darstellt oder Ihr Markenimage besser repräsentiert, machen Sie es. Aber das sind keine guten Gründe, mit B zu gehen, wenn B in einem Test schlechter abschneidet.

Fazit

Verlassen Sie sich nicht auf eine einzige Datenquelle und gehen Sie mit Ihrer Analyse tiefer, als nur die Gesamtergebnisse zu betrachten. Sie finden mehr Gewinne und haben bessere Daten, um Entscheidungen zu treffen. Die Integration Ihres Testtools in Google Analytics ist eine hervorragende Möglichkeit, dies zu tun.

(Dieser Beitrag wurde im September erheblich aktualisiert 2017)

Schließen Sie sich über 95.000 Analysten, Optimierern, digitalen Vermarktern und UX-Praktikern auf unserer Liste

E-Mails ein- oder zweimal pro Woche zu Wachstum und Optimierung an.