Come analizzare i risultati dei test A/B con Google Analytics

Strumenti di test A/B come Optimizely o VWO rendono il test facile, e questo è tutto. Sono strumenti per eseguire test e non esattamente progettati per l’analisi post-test. La maggior parte degli strumenti di test sono migliorati nel corso degli anni, ma mancano ancora ciò che puoi fare con Google Analytics, che è come tutto.

Quando si esegue un test fino a raggiungere la validità (non la stessa del significato), è necessario eseguire l’analisi post-test per decidere la via da seguire.

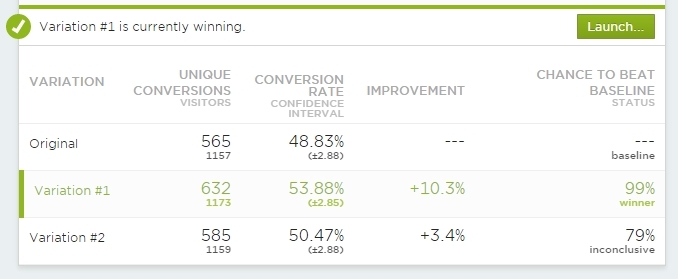

Guardare una schermata di riepilogo come questa non è sufficiente:

Usa queste viste at-a-glace per un rapido controllo per vedere qual è lo stato generale. Ma devi andare oltre una volta che il test è “cotto”.

Il test può davvero finire solo in 3 modi diversi:

- Controllo vince

- differenza

- Trattamento(s) vincere(s)

Anche quando il nostro strumento di test ci dice che questo è il risultato finale, che non è dove il nostro lavoro termina. È necessario condurre un’analisi post-test. E nella maggior parte dei casi è necessario farlo AL di fuori dello strumento di test. Certo: Optimizely ti consente di vedere i risultati in segmenti predefiniti, ma non è sufficiente.

È necessario integrare ogni test con Google Analytics

Sia VWO che Optimizely sono dotati di integrazioni Google Analytics integrate e i dati per ogni test devono essere inviati a Google Analytics. Non è solo per migliorare le capacità di analisi, ma anche per essere più sicuri nei dati. Il tuo strumento di test potrebbe registrare i dati in modo errato e, se non hai altra fonte per i tuoi dati di test, non puoi mai essere sicuro se fidarti o meno. Creare più fonti di dati.

7 Modi in cui l’analisi predittiva sta trasformando l’e-commerce

Di Gagan Mehra

L’analisi predittiva ti aiuta a capire cosa compreranno i tuoi clienti prima di farlo.

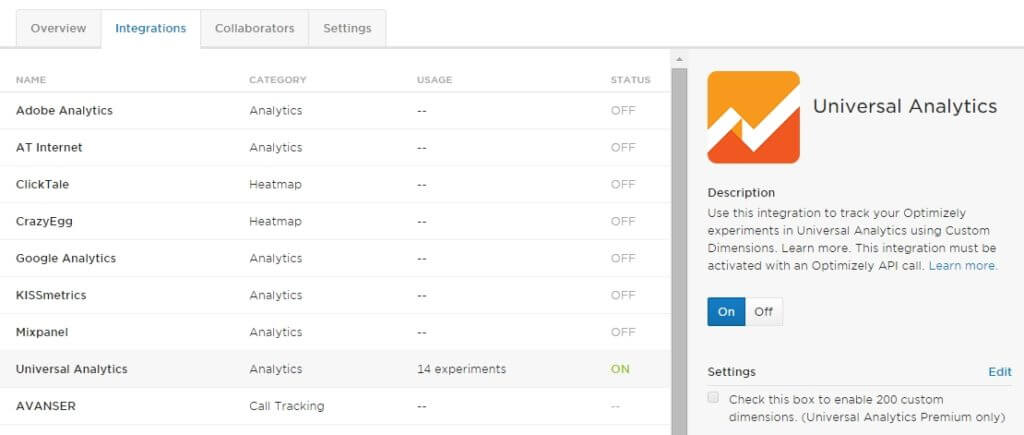

Optimizely Classico

In Optimizely Classica impostazione che l’integrazione con le Impostazioni di Progetto:

È sicuramente desidera utilizzare Universal Analytics, invece della Classica di Google Analytics. Se non hai ancora cambiato il tuo tracker GA, fallo il prima possibile.

Non solo sarai in grado di sfruttare le nuove funzionalità GA, puoi avere fino a 20 test A/B simultanei che inviano dati a Google Analytics. Con Classic è solo 5.

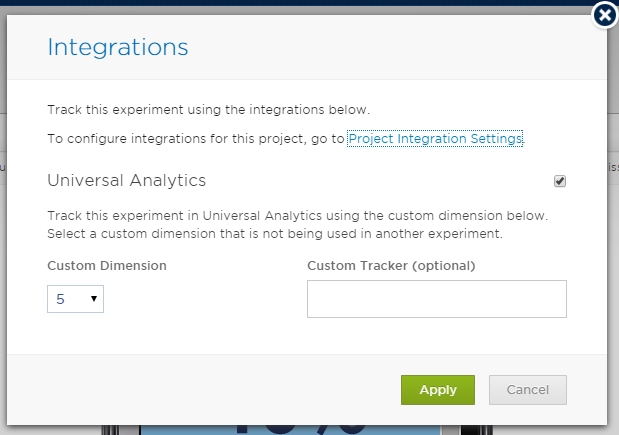

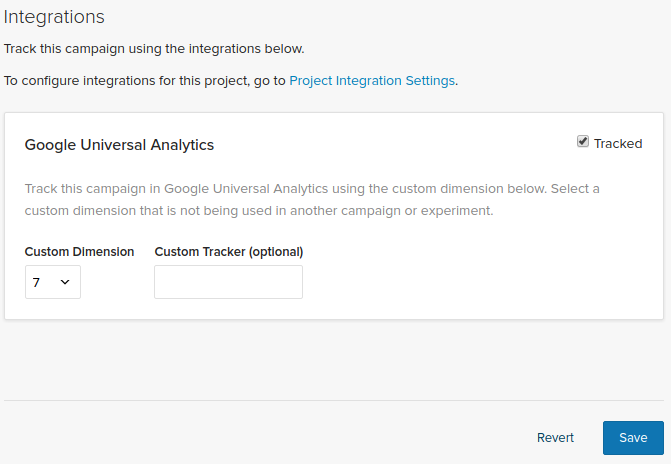

E una volta fatto questo a livello globale, è necessario scegliere una slot per ogni test:

assicurarsi che non ci sono più prove che utilizzano la stessa Dimensione Personalizzata (o Variabile Personalizzata per il Classico) slot in GA – sovrascrivono ogni altri dati, e ci si può fidare di più. Un test per fessura.

Il manuale di Optimizely ha anche istruzioni passo-passo per questa integrazione, incluso come impostare le dimensioni personalizzate.

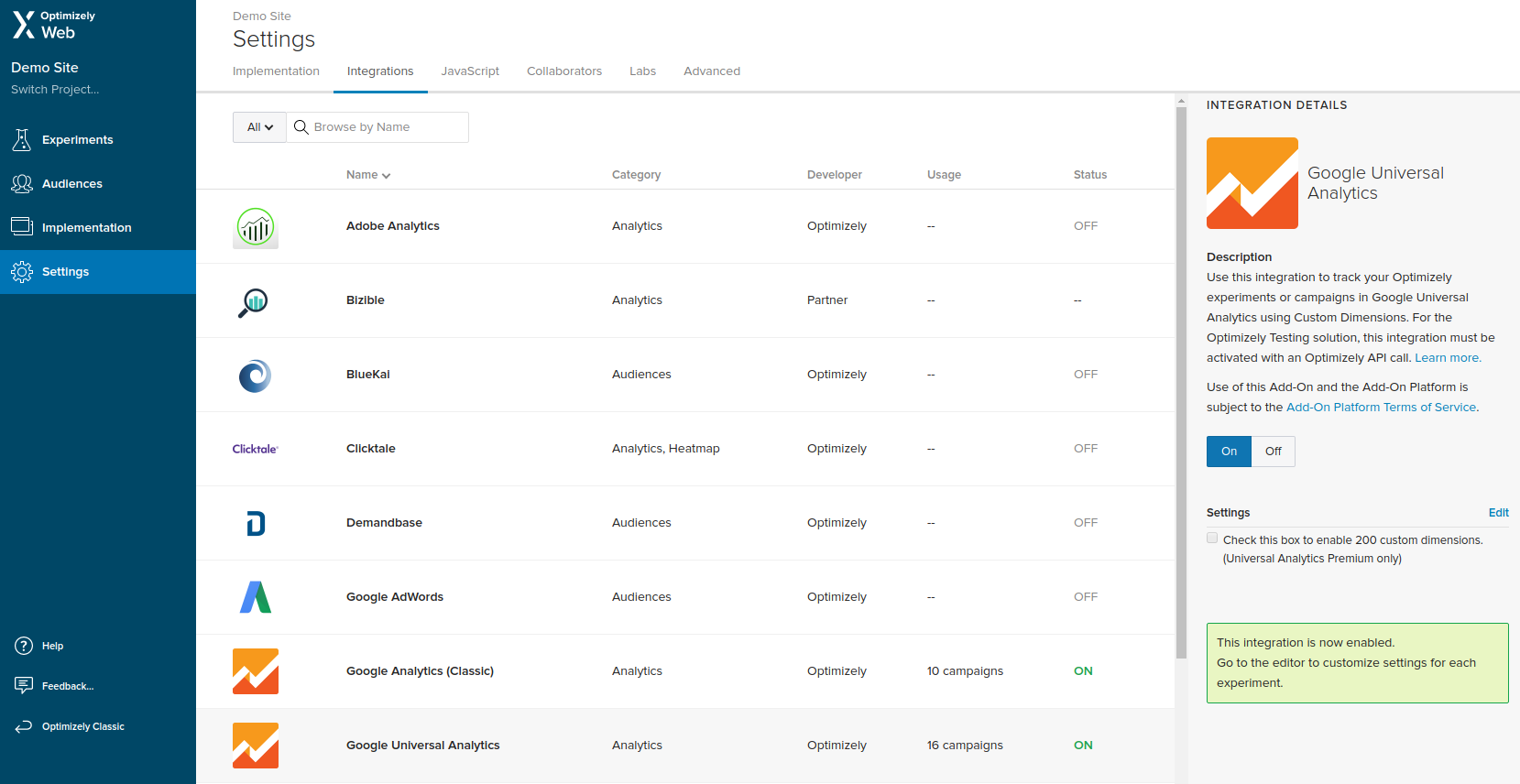

Optimizely X

In Optimizely X devi andare su Impostazioni e navigare su Integrazioni, lì puoi trovare Google Universal Analytics, accenderlo.

Una volta attivata l’integrazione a livello di Progetto, è necessario attivarla anche per ogni esperimento selezionando lo slot (Dimensione personalizzata).

Proprio come con Optimizely Classic, non si dovrebbe mai scegliere lo stesso slot per due test in esecuzione allo stesso tempo.

Per informazioni dettagliate su come ottenere l’integrazione in esecuzione, compresa la creazione delle dimensioni personalizzate in Google Analytics, dare un’occhiata alla guida sul loro sito web.

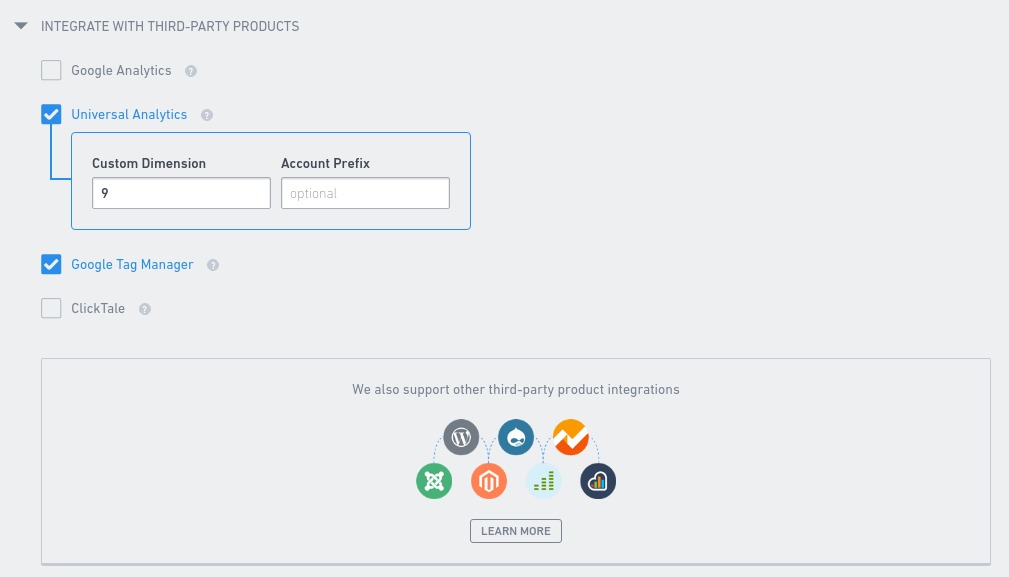

VWO

Quando si tratta di integrare Google Analytics con i tuoi esperimenti VWO, tutto ciò che devi fare è scegliere la giusta dimensione personalizzata nella scheda Altri delle Impostazioni dell’esperimento. Questo deve essere fatto con ogni esperimento.

Come con Optimizely, un esperimento attivo per dimensione personalizzata. In caso contrario si rischia di sovrascrivere alcuni dei dati di test memorizzati in Google Analytics.

Ulteriori informazioni sull’integrazione sono disponibili in un articolo della knowledge base di VWO.

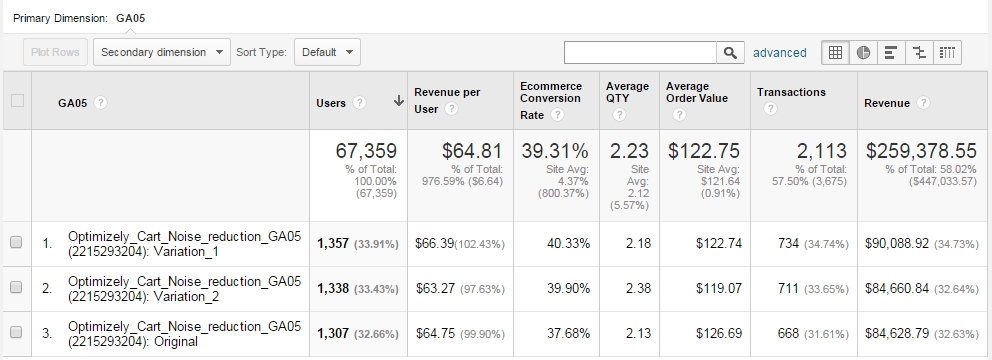

Accesso ai dati degli esperimenti in Google Analytics

Una volta fatto, puoi esaminare qualsiasi risultato del test in Google Analytics utilizzando report personalizzati. È possibile fare in modo che il report mostri TUTTI i dati desiderati:

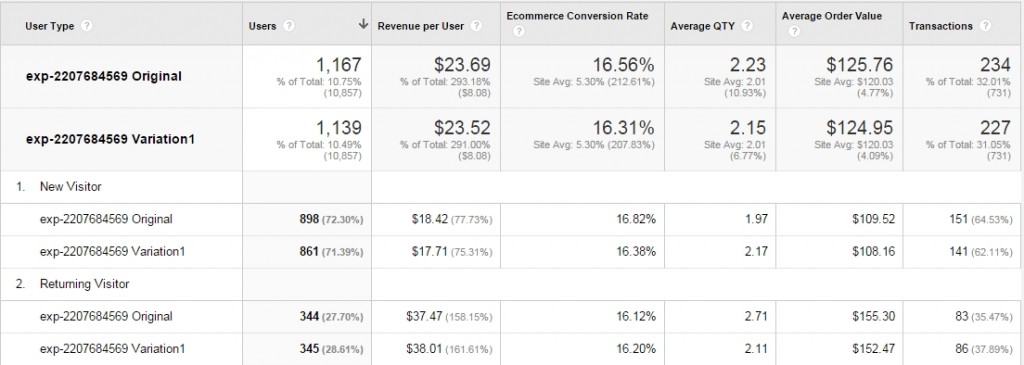

Qualche variazione ha più entrate per utente? Perché è così – bene diamo un’occhiata al valore medio del carrello o alla quantità media – queste metriche possono far luce qui.

Usa qualsiasi metrica utile nel tuo caso particolare. Scorri il report personalizzato utilizzato nell’esempio qui.

Nota che Google Analytics non ti dirà nulla sulla significatività statistica (valori p), i livelli di potenza, i margini di errore e così via. Avresti bisogno di estrarre quei dati in un foglio di calcolo Excel / Google o qualcosa in cui lo calcoli automaticamente. Non avviare l’analisi in GA prima che i dati siano cotti. Assicurati che la dimensione del campione e il significato necessari + i livelli di potenza siano presenti.

Invia variazioni come eventi per utilizzare segmenti avanzati (audience)

L’integrazione integrata di Google Analytics non è infallibile. A volte i dati non vengono trasmessi, c’è una discrepanza tra il 20% e il 50% – da qualche parte in qualche modo parte dei dati viene persa. Ci potrebbero essere numerose ragioni per questo, qualsiasi cosa, da come vengono caricati gli script, in quale ordine di timeout di script e altri problemi. Ho affrontato molti problemi diversi nel corso degli anni.

Il mio buon amico Ton Wesseling mi ha parlato per la prima volta di questa soluzione: invia un evento a Google Analytics ogni volta che viene caricata una variazione.

Tutto ciò che devi fare è aggiungere una riga al Javascript globale del test (eseguito per tutte le varianti), oltre a una riga di codice di monitoraggio degli eventi come ultima riga per ogni variazione del test.

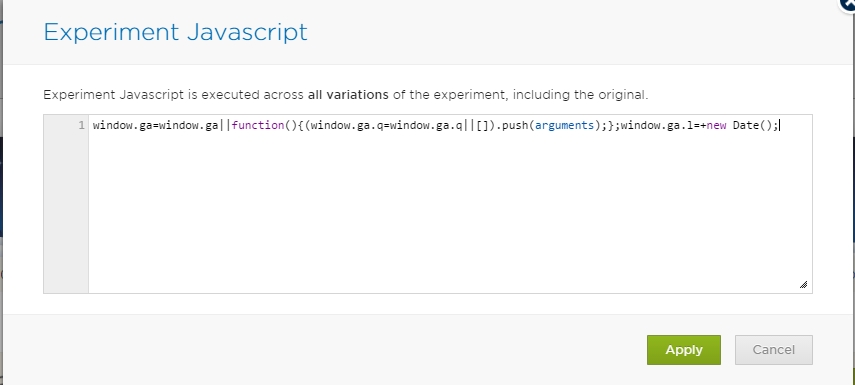

Quindi questa è la riga che dovresti aggiungere nella console Javascript di Global Experiment:

window.ga=window.ga||function(){(window.ga.q=window.ga.q||).push(arguments);};window.ga.l=+new Date();

Questo fa in modo che il tracker GA ottiene tutte le informazioni una volta che carica.

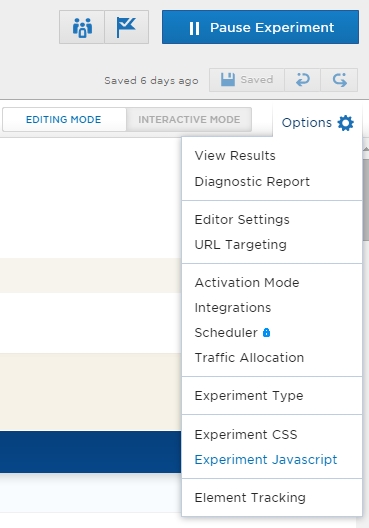

Ecco dove lo fai in modo ottimale. In primo luogo aprire le impostazioni durante la modifica di un test:

E ora scegliere Esperimento Javascript. Aggiungi il codice lì:

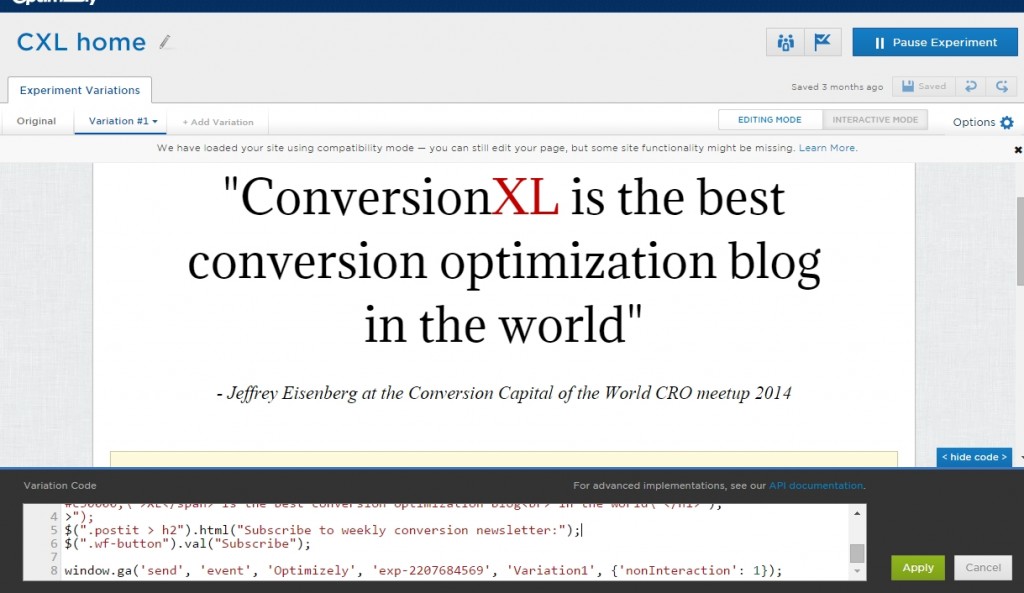

E ora è necessario aggiungere una riga di codice di monitoraggio degli eventi alla fine di ogni variazione (incluso l’originale). È necessario modificare solo il numero ID esperimento e il nome della variazione:

window.ga('send', 'event', 'Optimizely', 'exp-2207684569', 'Variation1', {'nonInteraction': 1});

Quindi ciò che fa il codice è inviare un evento a GA dove la categoria dell’evento è Ottimizzata, l’azione è l’ID esperimento (puoi ottenerlo dal tuo URL durante la modifica di un test) e l’etichetta è Variation1 (può anche essere originale, Variazione 2 ecc.). Non interazione significa che non viene registrato alcun coinvolgimento. Altrimenti la frequenza di rimbalzo per le pagine degli esperimenti sarebbe 0%.

Ecco dove aggiungi il codice in Optimizely:

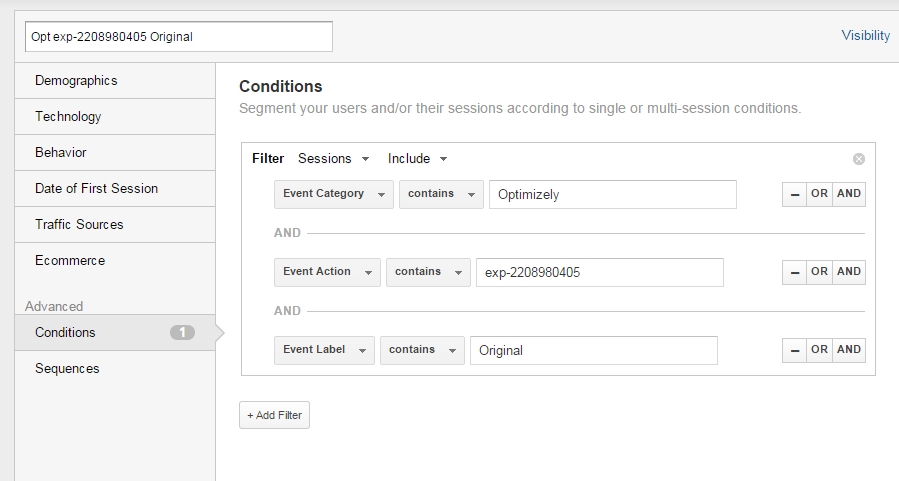

Ora sei in grado di creare segmenti in Google Analytics per ciascuna delle variazioni.

Configurazione segmento:

Creare segmenti separati per ogni variazione e applicarli a qualsiasi report desiderato. Così si poteva vedere qualcosa di simile:

Solo dati illustrativi.

La stessa cosa può essere ovviamente fatta con Dimensioni personalizzate. Assicurati che la coerenza dei dati sia lì-confronta le visite alle pagine di ringraziamento, i numeri delle entrate ecc.

Nessuna differenza tra le variazioni del test. E ora?

Diciamo che il risultato complessivo è “nessuna differenza significativa” tra le variazioni. Passare a qualcos’altro? Non cosi ‘ in fretta. Tieni a mente queste 2 cose:

1. La tua ipotesi di test potrebbe aver avuto ragione, ma l’implementazione ha succhiato

Diciamo che la tua ricerca qualitativa dice che la preoccupazione per la sicurezza è un problema. Quanti modi abbiamo per rafforzare la percezione della sicurezza? Illimitato.

Potresti essere a qualcosa-solo il modo in cui hai fatto qualcosa di succhiato. Se hai dati che supportano la tua ipotesi, prova qualche altra iterazione.

2. Solo perché non vi era alcuna differenza complessiva, il trattamento potrebbe avere battere il controllo in un segmento o due.

Se hai un passaggio nel restituire visitatori e visitatori mobili, ma un calo per i nuovi visitatori e gli utenti desktop – quei segmenti potrebbero annullarsi a vicenda, e sembra che sia un caso di “nessuna differenza”. Analizza il tuo test tra i segmenti chiave per vederlo.

Guarda i risultati del test almeno in questi segmenti (assicurati che ogni segmento abbia una dimensione del campione adeguata):

- Desktop vs Tablet/Mobile

- Nuovi e di Ritorno

- Traffico che atterra direttamente sulla pagina che si sta testando vs venuto via il collegamento interno

Se il trattamento eseguito bene per un segmento specifico, è il momento di considerare un approccio personalizzato per quel particolare segmento.

Non c’è differenza, ma ti piace B meglio di A

Siamo esseri umani e abbiamo preferenze personali. Quindi, se il tuo test dice che non c’è alcuna differenza significativa tra le variazioni, ma ti piace B meglio – non c’è davvero alcun motivo per non andare con B.

Se B è un miglioramento dell’usabilità o rappresenta meglio l’immagine del tuo marchio, fallo. Ma quelli non sono buoni motivi per andare con B se B si comporta peggio in un test.

Conclusione

Non fare affidamento su una singola fonte di dati e approfondisci la tua analisi piuttosto che guardare i risultati complessivi. Troverai più vittorie e avrai dati migliori per prendere decisioni. Integrare il tuo strumento di test con Google Analytics è un ottimo modo per farlo.

(Questo post è stato significativamente aggiornato settembre 2017)

Unisciti a oltre 95.000 analisti, ottimizzatori, marketing digitale e professionisti UX nella nostra lista

E-mail una o due volte alla settimana su crescita e ottimizzazione.